神经网络名词缩写及中英文对照 https://blog.csdn.net/counte_rking/article/details/78864795

UFLDL - Unsupervised Feature Learning and Deep Learning(无监督特征学习与深度学习)

CNN - Convolutional Neural Network (卷积神经网络)

FCN - Fully Convolutional Networks (全卷积网络)

RNN - Recurrent Neural Network (循环神经网络)

DNN - (深度神经网络)

Feedforward Neural Network 前馈神经网络(参照Mitchell的《机器学习》的翻译)

全联通网络 Full Connected Networks

稀疏编码 Sparse Autoencoder

前向输送 Feedforward

反向传播 Backpropagation

部分联通网络 Locally Connected Networks

连接区域 Contiguous Groups

视觉皮层 Visual Cortex

卷积 Convolution

固有特征 Stationary

池化 Pool

反向传播算法 Backpropagation Algorithm

(批量)梯度下降法 (batch) gradient descent

(整体)代价函数 (overall) cost function

方差 squared-error

均方差 average sum-of-squares error

规则化项 regularization term

权重衰减 weight decay

偏置项 bias terms; bias units

贝叶斯规则化方法 Bayesian regularization method

高斯先验概率 Gaussian prior

极大后验估计 MAP

极大似然估计 maximum likelihood estimation

激活函数 activation function

激活值 bias units

双曲正切函数 tanh function; hyperbolic tangent

非凸函数 non-convex function

隐藏层单元 hidden (layer) units

对称失效 symmetry breaking

学习速率 learning rate

前向传导 forward pass

假设值 hypothesis

残差 error term

加权平均值 weighted average

前馈传导 feedforward pass

阿达马乘积 Hadamard product

前向传播 forward propagation

神经网络neural networks

稀疏编码 Sparse Coding

无监督学习 unsupervised method

超完备基 over-complete bases

主成分分析 PCA

稀疏性 sparsity

退化 degeneracy

代价函数 cost function

重构项 reconstruction term

稀疏惩罚项 sparsity penalty

范式 norm

生成模型 generative model

线性叠加 linear superposition

加性噪声 additive noise

特征基向量 basis feature vectors

经验分布函数 the empirical distribution

KL 散度 KL divergence

对数似然函数 the log-likelihood

高斯白噪音 Gaussian white noise

先验分布 the prior distribution

先验概率 prior probability

源特征 source features

能量函数 the energy function

正则化 regularized

凸优化软件convex optimization software

共轭梯度法 conjugate gradient methods

二次约束 quadratic constraints

拉格朗日对偶函数 the Lagrange dual

前馈结构算法 feedforward architectures

LSE - Least Squares Method (最小二乘法)

一文搞懂深度学习:最全神经网络介绍 https://blog.csdn.net/2402_82802238/article/details/138549147

01 神经网络介绍

人工神经网络已经彻底改变了机器学习领域,并成为人工智能的基石,它的设计目的是模仿人类大脑的结构和功能,使计算机能够学习并做出类似人类思维的决策。

人工神经网络首次由神经生理学家沃伦·麦卡洛克和数学家沃尔特·皮茨于1943年提出,之后经历了起起落落,1960年后,随着支持向量机和其他强大的机器学习技术的进步,研究人员对神经网络的兴趣和激情有所下降,这些技术提供了更高的准确性,并具有更坚实的理论基础;神经网络复杂,需要巨大的计算能力和时间来训练,1990年后,计算领域的进步(参考摩尔定律)以及强大的GPU的生产重新引起了一些兴趣。

人工神经网络具有多功能性,适应性和可扩展性,使它们适用于处理大数据集和高度复杂的机器学习任务,如图像分类,语音识别,视频推荐或分析客户情绪等。

TOP10神经网络分类:

02 麦卡洛-皮茨神经元

麦卡洛-皮茨神经元是第一个数学神经元模型,由Warren McCulloch和Walter Pitts在1943年提出,它是神经科学和数学的结合,尝试通过数学和逻辑来解释神经元的行为,并为后来的人工智能和神经网络研究奠定了基础。

麦卡洛-皮茨神经元采用二进制输出方式,这意味着其输出非0即1,即神经元要么完全激活,要么完全不激活;这种设计灵感来源于生物神经元的“全或无”放电特性,是早期尝试用简化模型理解神经元行为的一种方式。

从数学上讲,可以将这个神经元写成如下形式:

虽然McCulloch-Pitts模型在处理现实世界的连续和复杂数据方面存在限制,但它在理论上非常重要,因为它证明了使用简单的数学模型可以模拟神经活动,并进行逻辑决策;这个模型为后续更复杂的人工神经网络模型,如感知机和多层前馈网络,提供了理论基础;同时,它还启发了对神经网络学习算法和计算机科学中并行计算概念的探索。

03 感知机

感知机模型1958年由Minsky-Papert提出,是最简单也是最早的神经元模型之一;它作为神经网络的基本单元,主要通过执行计算任务来识别输入数据的特征。

感知机接受实数值作为输入,每个输入都与一个权重相乘;如果加权输入的总和大于阈值,则神经元输出1,否则输出0。

从数学上讲,可以将这个神经元写成如下形式:

04 前馈神经网络

FNN是神经网络的最简单形式,信息单向流动,从输入到输出,没有任何循环;它们由一个输入层,一个或多个隐藏层和一个输出层组成;一般用于分类和回归等任务。

05 人工神经网络

ANNs的架构受到人类大脑生物神经网络的启发,由相互连接的层组成,包括输入层,隐藏层和输出层;每一层包含多个神经元,这些神经元与相邻层中的每个神经元相连。

当数据在网络中传输时,每个连接都会应用一个权重,每个神经元都会应用一个激活函数,如ReLU,Sigmoid或Tanh;这些函数引入了非线性,使得网络能够从错误中学习并做出复杂的决策。

在训练过程中,使用一种称为反向传播的技术来调整这些权重,这种技术使用梯度下降来最小化预定义的损失函数,旨在使网络的预测尽可能准确;ANNs使用案例包括客户流失预测,销售预测等。

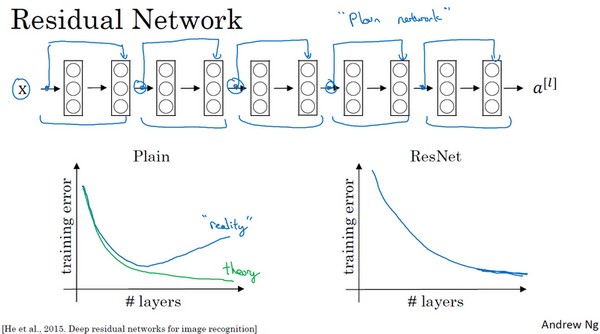

06 卷积神经网络

CNNs专门用于处理类似网格的数据,如图像和视频,它使用称为卷积层的专门层将一系列滤波器应用于输入图像,生成一组特征图。

然后,这些特征图通过池化层传递,降低它们的维度,使网络在计算上更有效率;最后,一个或多个全连接层执行分类。

训练过程涉及反向传播,类似于人工神经网络,但专门设计了用于保留特征的空间层次结构。

CNNs广泛应用于计算机视觉任务,如图像分类,目标检测和图像分割。

07 循环神经网络

RNNs专为处理序列数据设计,输入的顺序对结果影响重大;这类网络特有的循环连接结构,能够将信息从一个时间点传递至下一个,因此非常适合处理时间序列数据;在这一过程中,每个神经元都能通过其内部状态,记忆并利用之前时间点的信息。

在处理数据时,网络能够同时处理当前和之前的输入,这为其提供了一种短期记忆的功能;然而,RNNs面临着梯度弥散和梯度爆炸的问题,这些问题使得网络难以学习数据中的长期相关性。

为了解决这些问题,人们开发了更先进的模型,例如长短期记忆网络(LSTM)和门控循环单元(GRU)。

RNNs广泛应用于自然语言处理、语音识别和时间序列分析等领域。

08 长短期记忆网络

长短期记忆网络(LSTM)属于循环神经网络(RNN)的一种,它有效地解决了梯度消失的问题,使得网络能够更好地处理序列数据中的长期依赖性;LSTM尤其适合于处理那些需要识别和预测时间序列中复杂模式的任务。

09 门控循环单元

门控循环单元(GRU)与长短时记忆网络(LSTM)一样,是一种循环神经网络;它有效地解决了梯度消失的问题,并且能更好地学习长期依赖关系;由于GRU结构相对简单,当计算效率成为重要考虑因素时,它通常会被优先选择。

10 深度信念网络

深度信念网络(DBNs)是一种神经网络,它由多层受限玻尔兹曼机(RBMs)构成;受限玻尔兹曼机属于概率神经网络,主要功能是学习和模拟给定数据集的概率分布;深度信念网络广泛应用于图像分类和自然语言处理等任务。

11 生成对抗网络

生成对抗网络(GANs)是由两个神经网络构成的系统,包括一个生成器和一个鉴别器;这两个网络在一种竞争式的训练环境中相互对抗;生成器的任务是创造出难以与真实数据区分的数据,而鉴别器的任务则是尽可能准确地识别出哪些是真实数据,哪些是生成器产生的数据。

生成对抗网络广泛应用于图像生成、风格转换和数据增强等领域。

12 自编码器

自编码器主要应用于无监督学习和特征提取;它由编码器和解码器组成;编码器负责将输入数据转换为低维的潜在表示,而解码器则从这种潜在表示中重构出原始数据。

自编码器广泛用于降维,异常检测等多种任务。

13 自组织映射

自组织映射(SOMs)是一种用于处理高维数据的技术,它可以将这些数据在低维空间中进行聚类和可视化;这种方法属于无监督学习,通过将输入数据映射到一个低维的网格上,能够有效地保持数据点之间的相对位置和连通性,即保留了它们的拓扑结构。

14 径向基函数网络

径向基函数网络(RBFNs)是一种常用于模式识别和函数逼近的神经网络;这种网络的隐藏层神经元使用径向基函数作为激活函数;当输入与输出之间的关系呈非线性时,径向基函数网络尤其有效。

15 Transformers

Transformers采用了一种全新的方法,摒弃了递归结构,完全依赖注意力机制来学习序列元素之间的关系,这些关系是基于元素的整体重要性来确定的;研究人员已经将Transformers应用于自然语言处理领域,通过开发像谷歌的BERT和OpenAI的GPT-3这样的模型,在机器翻译、文本分类和语言建模等方面取得了突破性的成果;Transformers对于提升深度学习模型处理语言数据的能力做出了显著贡献。

16 图神经网络

许多神经网络主要处理的是像图像或文本这样的欧几里得数据,而图神经网络则是为了处理图数据而特别设计的,这种数据包含了复杂的元素间关系;图神经网络扩展了传统卷积网络的技术,比如将滤波方法应用于图结构数据,并能够根据图的结构和节点的特性来学习节点的表示。

图神经网络在链接预测,节点分类和社区检测等多种网络任务中表现出了极高的准确性;这些网络在处理密切相关数据的应用场景中展现了巨大的潜力。

17 深度Q网络

深度Q网络(DQNs)在深度强化学习领域,尤其是在掌握复杂游戏方面,取得了重大突破;DQNs通过使用神经网络来近似函数,估算出决定最优行动的Q函数的价值,从而最大化预期的奖励;Nvidia的研究团队将卷积神经网络(CNNs)与Q学习相结合,应用于DQNs,成功地在多款Atari 2600游戏中达到了人类水平的表现;随后,DeepMind利用DQNs在3D游戏中超越了人类的表现,并且还精通了围棋;在深度强化学习领域,DQNs的应用仍然非常广泛。

18 高斯过程

大多数深度学习方法通过判别学习来建立输入与输出之间的条件概率模型,而高斯过程则通过概率回归来直接预测连续变量;这种方法依据一组观测数据来建模函数的分布,并能提供对预测结果不确定性的估计。

高斯过程在黑箱优化和模型不确定性可视化方面展现出了极高的灵活性;当高斯过程与神经网络结合使用时,可以显著提升预测的准确性。

19 总结

本文综述了人工神经网络的多种类型及其应用;从最初的麦卡洛-皮茨神经元到复杂的Transformers,每种神经网络都有其独特之处;感知机作为早期模型,前馈神经网络处理直接信息流,而卷积神经网络则擅长图像处理;循环神经网络和LSTM适合序列数据,而生成对抗网络在数据生成方面表现出色;自编码器用于特征提取,自组织映射处理高维数据可视化,径向基函数网络适用于模式识别;图神经网络处理非欧几里得数据,深度Q网络在强化学习中取得突破,高斯过程则提供连续变量预测;这些神经网络共同推动了机器学习领域的发展,解决了各种复杂问题。