TowardsDataScience 博客中文翻译 2022(二十九)

原文:TowardsDataScience

协议:CC BY-NC-SA 4.0

如何使用计算机视觉读取酒瓶上的标签?(第一部分)

原文:https://towardsdatascience.com/how-to-read-a-label-on-a-wine-bottle-using-computer-vision-part-1-25447f97a761

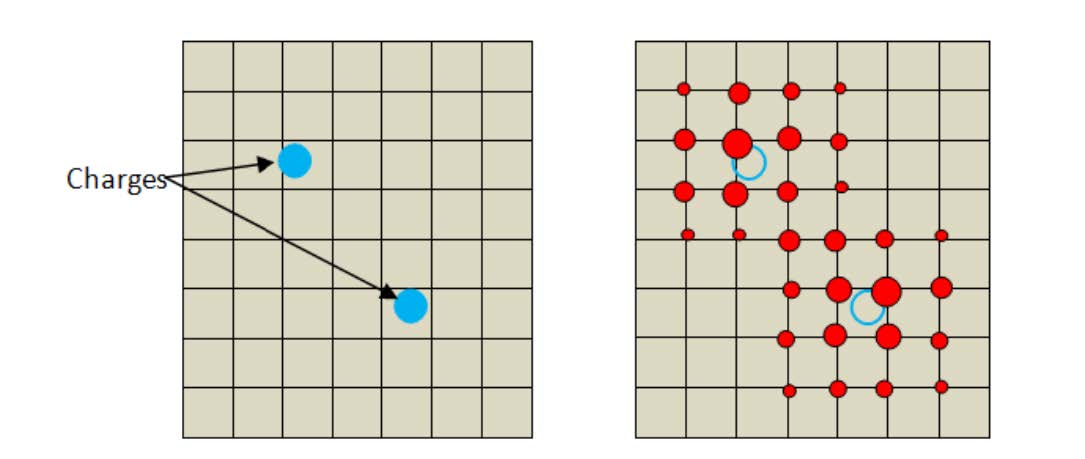

欢迎阅读本系列文章,在这里我将解释我构建第一个计算机视觉项目的历程。这里的目标是让计算机从一张简单的照片上读出一瓶酒的标签。你可能会问,为什么这很复杂?首先,我们不能直接调用像 tesseract 这样的 OCR(光学字符识别)库,因为标签上的文本在圆柱体上是扭曲的,正因为如此,我们不能正确地提取字符,从而提取单词和句子。

为了实现这一点,我们需要将我们的问题分解成不同的具体任务,以成功地阅读写在酒瓶标签上的内容。但首先我们需要向我们的机器解释什么是酒瓶标签,以及如何检测它。

第 1 部分—检测标签,图像处理方法

在我最初的研究阶段,我偶然发现了一个很棒的 mathematica 论坛帖子,作者试图做或多或少相同的任务,但是是在果酱罐上。在这个过程中,作者使用不同的图像处理技术来尝试定位标签的位置。所以我当然尝试用 python、opencv 和我自己的酒瓶照片来复制这个。让我们以这张照片为例:

首先,从计算机视觉的角度来看,这张照片有一个巨大的好处:标签和背景之间有很多对比度,如果我们试图用图像处理来分离标签,我们可以希望得到一些好的结果。

因此,让我们开始检测标签的位置:首先,我们将图像转换为灰度,并应用一个自适应阈值函数来帮助我们简化图像的结构。只考虑图像的对比度。

该自适应阈值功能参数对该方法的成功非常重要,目标是获得标签周围的粗轮廓线。我必须迭代并找到适合我的参数:{blockSize : 35,C : 4}。

一旦这样做了,下一步我发现有用的是模糊图像一点点,以平滑图像轮廓,并应用一个简单的二进制阈值,只得到白色和黑色。在这些步骤中,参数也是手动调整的,以获得可能的最佳结果。

一旦我们可以清楚地看到标签的轮廓,我们可以希望 opencv 上可用的 Canny 函数将在我们的图像上绘制所有检测到的边缘,并允许我们通过使用按最大面积排序的 findCountours 函数来精确选择它的位置:

在这里,我们成功地找到了我们的标签的相对位置,所以我们可以开始工作,并希望阅读上面写的东西!

…等等,让我们先在其他照片上试试我们的算法,当然它也适用于其他图像。

…是的,它对其他图像根本不起作用,因为每个上下文都是唯一的,我们的算法是参数化的,以对我们最初选择的图像起作用。在我的下一篇文章中,我将在神经网络魔法的帮助下,为这个问题找到一个系统化的解决方案,在一个广义的环境中更好地工作!

与此同时,你已经可以在我的网站上亲自尝试该项目的当前版本的现场应用,只需用你的智能手机连接到该网站,上传一张照片,等待一分钟,你应该会得到结果。

[更新]下面是第 2 部分的链接:https://medium . com/@ leroyantonin . pro/how-to-read-a-label-on-a-a-a-wine-bottle-using-computer-vision-part-2-8bd 047 D2 a945

所有图片均由作者

如何使用计算机视觉读取酒瓶上的标签?(第二部分)

原文:https://towardsdatascience.com/how-to-read-a-label-on-a-wine-bottle-using-computer-vision-part-2-8bd047d2a945

欢迎阅读本系列文章,在这里我将解释我构建第一个计算机视觉项目的历程。这里的目标是让计算机从一张简单的照片上读出一瓶酒的标签。在我们的上一篇文章中,我们尝试了一种非常直接的方法,用 python 和 OpenCV 图像处理技术来检测我们的葡萄酒标签,我们发现在一组不同的照片上检测葡萄酒标签还不够好。

对于这个项目的第二部分,我们将尝试其他方法来解决这个问题,我们将尝试建立一个神经网络,它可以基于监督方法来识别标签的位置。

第 2 部分—检测标签,神经网络方法(U-net)

在我第一次尝试第一种方法失败后,我开始怀疑我是否能找到一种只使用 OpenCV 的方法,当我偶然发现一个论坛帖子时,有人正试图做几乎和我一样的事情,除了邮件上的标签。这个问题的一个回答引起了我的注意:

一个只有 5 个标记样本的 U-Net 将很容易检测到它。你只需屏蔽标签区域,通过一些良好的增强,如随机旋转/翻转/扭曲,你将获得可靠的结果,你可以稍后使用

findContours或boundingRect预测屏蔽。

然后我开始研究 U-net 以及如何实现它。基本上,我必须为训练集中的每个标签形状图像(X)手动创建一个相应的黑白遮罩(U-net 的目标),如下所示:

有趣的部分开始了,我总共花了 2/3 个小时的 photoshop 来制作 163 张照片的标签蒙版!完成后,我找到了这个网络架构的 tensorflow 实现。以下是来自维基百科的网络架构描述:

这个网络由一条收缩路径和一条扩张路径组成,这使它具有 u 形结构。收缩路径是一个典型的卷积网络,它由重复应用的卷积组成,每个卷积之后是一个整流线性单元 (ReLU)和一个最大汇集操作。在收缩期间,空间信息减少,而特征信息增加。扩展路径通过一系列上卷积和连接将特征和空间信息与来自收缩路径的高分辨率特征相结合。

这是 tensorflow 实现的样子(忽略配置文件,它是我为自己的包设置的):

我在我自己的 NVIDIA GeForce RTX 3060 上训练网络。大约 10 分钟后,验证准确度开始收敛到 99%左右。

张量板训练可视化

让我们在一些样本照片上测试我们的模型,看看我们的网络在真实条件下表现如何。

样本外预测示例

正如您在这里看到的,一切都按预期工作,网络的输入必须经过一点点预处理,才能成为方形,并且是 BGR 彩色格式。一旦获得预测掩码,我们只需要调整它的大小,以获得标签的像素坐标(白色像素)。

样本外预测示例

在这里,除了被误认为是标签一部分的小光点之外,网络也工作得相当好。

样本外预测示例

在这个例子中,瓶子旁边有一本书,我们看到网络变得混乱,并将它的一部分包含到标签的形状中。即使这是一个非常健壮的方法,仍然有一些改进的空间。对于这个项目,我将使用这种方法来检测标签,并尽可能避免这样的错误,我会给出摄影指南(中心标签/无旋转/良好的照明/良好的背景对比度),以尽量减少网络的错误。

这就是第 2 部分的全部内容。如果你想了解更多关于 U-net 是如何设置的,并探索代码,你可以查看位于 https://github.com/AntoninLeroy/wine_label_reader_toolkithttps://github.com/AntoninLeroy/wine_label_reader_toolkit的 GitHub 项目资源库

在下一篇文章中,我们将尝试找到一种方法来使我们的标签圆柱体变平,以便能够用 OCR 库读取它,敬请关注!

我们的实时应用程序仍然可以在:https://plural.run/wineReader

【更新】第三部出来了!点击这里。

所有图片均由作者提供

如何使用计算机视觉阅读酒瓶上的标签(第三部分)

原文:https://towardsdatascience.com/how-to-read-a-label-on-a-wine-bottle-using-computer-vision-part-3-e4729e5a8140

欢迎回到本系列文章。提醒一下,在我们的前两篇文章(第一部分、第二部分)中,我们探索了两种不同的方法来尝试检测酒瓶上标签的位置。

在项目的当前阶段,我们能够将酒瓶的照片输入到我们训练过的 U-Net 型神经网络,并获得黑白蒙版作为输出,该蒙版定位标签的估计位置:

预测的例子

下一个具有挑战性的步骤是移除标签上的所有曲率,这样我们就可以对我们的扁平化标签应用 OCR,并成功检测上面写的单词和句子。

在我的研究过程中,我有机会偶然发现了一个很棒的 github 项目,它是由阿列克谢·赞克维奇完成的。在使用他的库和写这篇文章之前,有必要提一下**,我请求他正式授权使用他的代码,并在这篇文章中提到他的工作**。

我不会详细解释他的库是如何工作的,因为我根本没有编码它,我也不掌握他使用的几何概念,但简单地说,这个库允许通过在标签圆柱体边缘周围手动定位 6 个点来“解开”葡萄酒标签。然后,代码生成并映射许多点,这些点遵循估计的圆柱体几何形状,并使用 scipy 库将这些点的插值应用到几何形状平坦的目标地图。通过这样做,我们得到了一个平面标签的视觉近似。

问题是,我们需要找到一种方法来自动定位我们的 U-Net 图像预测上的这 6 个点。让我们举一个我们会用到本文结尾的照片例子:

原始 256*256 U_net 预测

一旦我们得到了我们的 U-net 预测,我们需要将它重新整形回原始源照片的大小,这样,一旦我们找到了我们的 6 点坐标,我们就可以将它们正确地放置在原始照片中。此外,我们希望标签垂直对齐,我们只想要二进制颜色(黑色或白色像素)。为此,我们使用包的 readLabels 方法中的这段代码。

调整大小、二值化和对齐的 U-net 预测

关于我实现的垂直对齐算法说几句,它只是试图最大化全黑列的数量,所以在这里你可以看到我们不能说对齐是完美的,因为圆柱体形状的一些不完美的检测,但我选择不采用完美的例子来表明它在不完美的情况下工作。

现在让我们来谈谈我是如何估计和定位我们需要使用展开标签代码的 6 个点的。我的想法是先找到一种迭代的方法来检测角,因为在垂直对齐算法中,我使用了“全黑列”的逻辑作为继续迭代的条件,所以基本上:从一边扫描到另一边,只要有一列至少有 1 个白色像素就停止,等等。但问题是,我没有用这种逻辑找到所有的角,因为通常圆柱体都有透视,因此顶部或底部比另一个大…

然后我想起了矩阵对角线!如果我能找到一种像这样用对角线迭代的方法,而不是用列和行迭代,会怎么样呢?

拐角/边缘检测逻辑

这样我就能找到 A,C,D 和 F 坐标点的对角线,并通过计算简单的距离找到 B 坐标:

其中 XB 是点 b 的 X 坐标。我们现在可以选择对应于该 XB 位置的图像的列向量(λ):

是的,我知道这是一个疯狂的非正统的数学符号

我们在向量中从上到下迭代,找到第一个白色像素来减去 B 点的 Y 坐标。

对于 E 点,逻辑是相同的:我们在 D 点和 F 点的中间找到列向量,这次我们从下到上迭代,直到找到第一个白色像素。

要获得实现的细节,请查看包中的方法【getCylinderPoints】。

现在我们有了 6 个坐标,我们可以使用“展开标签”代码。

网状圆柱投影

展平标签

TADA!最后,我们现在有了一个几乎完美的平面标签,可以尝试在上面应用 pytesseract OCR 库。为了看到原始(弯曲的)图像和展平的图像之间的差异,我把两个 OCR 副本放在一起,以证明我们没有白做这些工作!

原始图像 OCR:

酱汁控制

DE RESERVE

_ftes Lo

2020法国产品的所有者

展平标签图像 OCR:

索穆尔市所有人盖泰·德索穆尔

奥穆尔

索默控制器

DE 储备

2020

法国产品

所以它绝对不是完美的,但肯定有所改善。照片本身有一些照明差异,似乎会影响光学字符识别。以下是我测试的其他几个例子:

原始图像 OCR:

R

ORDEAUX SUPER!伊利厄

APDE 波尔多特级葡萄酒

展平标签图像 OCR:

从 5 月 8 日开始

一天

边境安全

穆林-德茹尔

+S a

(一氧化碳)

波尔多特级葡萄酒

波尔多特级酒庄

原始图像 OCR:

帕夫

| i YS dD' :

= UE e :

:桑斯 SUL

:艾特斯阿约特斯

ARD 贝特朗在栅栏

oL0 oul便便

:

p

R

O

D

U

IT

DE F

RA新天主教版本(New Catholic Edition)

展平标签图像 OCR:

MS22338

2020

西拉·罗斯

支付现金

无亚硫酸盐葡萄酒

CEeRTiFre

杰拉德·贝特朗

农业

法国产品= sos:

我想我们已经完成了我的第一个计算机视觉项目的系列文章。您可能已经发现了这一点,它远非完美,有些步骤还可以优化:

- 拐角/边缘圆柱体检测是我提出的解决这个算法任务的一种方法,但是我确信也许可以找到另一种解决方案。

- 在我看来,OCR 部分本身是一项非常懒惰的工作,它可以通过使用默认配置之外的其他配置进行更好的优化,并可能增加一个图像处理步骤来减少可能产生一些噪声的阴影/照明或背景对象。

- 标签形状检测 U-Net 在预测方面远非完美,经常无法找到几何上正确的圆柱体,我相信实验计算机视觉工程师会找到一种方法,通过更多的深度学习工作或图像处理技术来提高其效率。

如果您有一些改进此解决方案的建议,请随时评论或联系我。你可以在https://plural.run/wineReader用你自己的酒瓶照片测试这个应用程序(记住,它们应该有一个好的分辨率,尽可能少的透视和与标签高对比度的背景)。

所有图片均由作者提供。

如何阅读熊猫中的卡夫卡点击流事件数据

原文:https://towardsdatascience.com/how-to-read-kafka-clickstream-event-data-in-pandas-96f50e88f7eb

构建 Kafka 消费程序以读取 Jupyter 笔记本中特定日期范围内的事件数据

照片由乔纳森派在 Unsplash 上拍摄

背景

最近,我被分配了一个看似简单的任务→

“我们开始从一个新的应用程序中捕捉事件。你能证明这样的测试事件在卡夫卡那里是正确的吗?”

我对我们系统中的数据流有一个粗略的想法:从 Web 和移动应用程序收集的点击流数据将首先流向 MetaRouter,然后 MetaRouter 作为 Kafka 生产者,为某个 Kafka 主题生成事件日志。我们的新应用程序生成的事件有一个共享的writeKey。因此,为了阅读这些事件,我需要:

- 创建一个卡夫卡消费者来听这个卡夫卡话题

- 因为我知道这样的测试事件是在特定的日期范围内产生的,所以我想为指定的日期构建 Kafka 消费者只读事件。

- 以一种我可以过滤和分析的方式存储数据,最好是在熊猫的数据框架中。

所以我的目标是实现卡夫卡->熊猫的数据流!

在谷歌搜索了 StackOverflow、GitHub 和各种网站很多天后,我终于让它工作了!下面是我关于如何在 Kafka 的两个最流行的 python 库中实现的代码片段。

解决方案 1:使用“kafka-python”库

必备: pip install kafka-python(我的笔记本用的是最新版本 2.0.2)

首先,我们需要导入下面的库和 Kafka 环境变量。下面的设置脚本可以在解决方案 2 中重复使用,只需稍作修改。

接下来,构建一个 Kafka 消费程序来读取特定日期时间范围内的事件。有 5 个步骤:

- 步骤 1 :因为我知道测试事件是在 2022–09–22 之间的 12 点至 14 点(UTC)时间发送的,所以我使用

datetime函数创建dt_start和dt_end来限定时间范围。 - 第二步:在 Kafka 中,只有来自同一个分区的事件才是有序的,所以我们需要从指定的分区读取事件。(假设您有 6 个主题分区,您可以从 0-5 中选择任意一个数字作为分区)。

- 第三步:基础消费者要求

topic、bootstrap_servers和group_id。我发现在 Jupyter 笔记本中,如果我不提供security_protocol它就会抛出错误。 - **第四步:**这是关键!它的工作方式是这样的:

- datetime 对象→转换为 UTC 时间戳(单位为毫秒)→转换为主题分区中的相关偏移量

-基本函数是consumer.offsets_for_times({tp:dt_start.timestamp()*1000})

- datetime 对象→转换为 UTC 时间戳(单位为毫秒)→转换为主题分区中的相关偏移量

- 步骤 5: 使用

seek获取从期望的开始时间

开始的事件——每个消息都有一个属性offset,我们将它与期望的结束时间偏移进行比较,以决定是继续还是中断

说够了,下面是完整的代码→

之后,我可以在熊猫里查询我们新应用的writeKey!🐼

上述解决方案受到 StackOverflow 的类似问题的启发。实际上,这是我开始做大量搜索的地方,发现没有使用confluent-kafka的等价解决方案。由于我的原始代码是基于confluent-kafka而不是kafka-python,我对它们表面上的相似性和细微差别感到困惑。

现在我很高兴使用confluent-kafka介绍我自己的解决方案😃~~~

解决方案 2:使用“汇合-卡夫卡”库

先决条件: pip install confluent-kafka(我的笔记本用的是最新版本 1.9.2)

在这里,您可以使用解决方案 1 中的相同设置脚本,只需稍作修改:

- 将第 10 行改为

from confluent_kafka import Consumer, TopicPartition

接下来,我们需要构建一个 Kafka 消费者来读取特定日期时间范围内的事件。在高层次上,我们仍然需要同样的 5 个步骤,但是主要的区别是我们需要使用on_assign来实现seek所做的——从主题分区中获取特定的偏移量。

步骤 1: 和解决方案 1 一样,我们需要 datetime 对象来限定搜索范围。

第二步:同方案一。一个比较棘手的事情就是大部分时候你可以用 string 作为 topic 比如topic = 'analytics__pageview',但是当你要subscribe的时候,它只接受一个 list 比如consumer.subscribe(['analytics__pageview'])!(就像邓布利多可能会说的:“多么希望如此~ ~”🧙

步骤 3: 除了将变量赋值中的=替换为:之外,几乎与解决方案 1 相同。

**第四步:**下面是你将看到的细微差别!我们需要一个额外的步骤4c来建造on_assign。而这个功能最初是来自 Magnus Edenhill 提供的github confluent-Kafka-python issue。

步骤 5: 这里我们不使用seek,而是使用subscribe和主题(列表形式)以及on_assign来获取所需开始时间的偏移量。而且取数后我们需要调用close()。

还有一个值得注意的细节是,如何得到偏移量。

在kafka-python中,你用的是offset_start[tp].offset,offset_start是字典。

offset_start = consumer.offsets_for_times({tp:dt_start.timestamp() * 1000})# to print out the offset number

offset_start[tp].offset

输出:(注意表示类型的是 dict)

在confluent-kafka中,offset_start是一个列表,所以需要使用offset_start[0].offset

tp_in = TopicPartition(topic=topic, partition=partition, offset=int(dt_start.timestamp() * 1000))offset_start = c.offsets_for_times([tp_in])# to print out the offset number

offset_start[0].offset

输出:(注意[ ]表示类型是 list)

好的,这是实现confluent-kafka的完整代码

摘要

- 构建事件驱动的应用程序是一种趋势,我预见到对数据科学家能够快速处理和对事件数据进行简单探索分析的需求会不断增长。这可以帮助通知哪些数据字段应该被进一步转换并引入 ETL 管道,这可能应该涉及

Faust和ksql而不是pandas.

如何非迭代地读取多个 CSV 文件(并且没有熊猫)

原文:https://towardsdatascience.com/how-to-read-multiple-csv-files-non-iteratively-and-without-pandas-984fd954999c

对熊猫的读 CSV 方法说不!

Solaiman Hossen 在 Unsplash 上拍摄的照片

Pandas 的一个主要警告是它不能扩展到多个 CPU 核心(通常)。本质上,当您运行任何操作时,在理想情况下并行化是可能的,Pandas 仍将坚持传统的单核执行,而其他内核将闲置。当您构建大规模应用程序时,这一点尤其重要。

处理大规模数据驱动的应用程序需要通过优化算法来加快执行速度,并消除/减少管道中每一个可能的位的运行时间。在我看来,经常被忽视的一个领域是优化输入输出操作。

假设您有数百个 CSV 文件需要读入 python 环境。毫无疑问,你的第一选择是熊猫。另外,即使您没有处理大量的 CSV 文件,我也总是建议您删除所有的 CSV 文件,将它们转换为相对更快、存储效率更高的文件,比如 Pickle、Feather 或 Parquet。

如果你必须使用 CSV,我个人不推荐使用熊猫的 CSV 读写功能,你可以在我下面的帖子中找到答案。

因此,回到我们的数百个 CSV 文件的场景,在这里,读取多个 CSV 文件的一种简单方法可以是在一个循环中迭代它们,获得 Pandas 数据帧的列表,并将该列表连接成单个数据帧。这将在下面演示。

使用 Pandas 读取多个 CSV 文件的代码片段(图片由作者提供)

但是,这种方法存在一些问题:

- 该循环不可避免地引入了一个迭代过程,即一次只能读取一个 CSV 文件,从而导致资源利用不足。

- Pandas read-csv 方法本身是一个序列化的过程。

这篇文章旨在解决上述两个与熊猫有关的读取多个 CSV 文件的问题,我们将在这篇文章中探索数据表。

Datatable 是一个用于操作表格数据的 python 库。它支持内存不足的数据集、多线程数据处理和灵活的 API。

使用数据表读取多个 CSV(非迭代):

下面的代码片段演示了如何使用 DataTable 读取多个 CSV 文件。

使用数据表读取多个 CSV 文件的代码片段(图片由作者提供)

实验设置:

- 出于实验目的,我用 Python 生成了 10 个不同的随机 CSV 文件,每个文件有 10 万行和 30 列——包括字符串、浮点和整数数据类型。

- 我重复了下面描述的实验五次,以减少随机性,并从观察到的结果中得出公正的结论。我下面报告的数字是五次实验的平均值。

- Python 环境和库:

- Python 3.9.12

- 熊猫

- 数据表 1.0.0

实验:读取所有 CSV 文件所花费的时间

下图描述了 Pandas 和 DataTable 读取十个 CSV 文件并生成一个Pandas 数据帧所花费的时间(以秒为单位)。

描述熊猫和数据表读取 CSV 文件所用时间的条形图(图片由作者提供)

- 实验结果表明,在读取 CSV 文件时,与 Pandas 相比,的速度提高了两倍多。

- 与 Pandas 相反,这些结果也为 DataTable 采用的多线程方法提供了证据。

结束语

老实说,我不太喜欢 CSV。如果你通读了我之前的帖子(我在上面链接了)和你现在正在读的帖子,你可能也会和我产生共鸣。自从我发现与 CSV 相关的众多问题后,我尽可能地停止使用它们。

总之,我认为除非您需要在非 pythonic 环境(如 Excel)之外查看数据框架,否则根本不需要 CSV。更喜欢像拼花地板、羽毛或泡菜这样的格式来存储你的数据帧。尽管如此,如果您看不到其他选择,至少通过利用 DataTable 而不是 Pandas 来优化您的输入和输出操作。

毒枭迷因由作者使用 MemesPortal.com 创造。

如何阅读研究论文:面向 ML 从业者的实用方法

原文:https://towardsdatascience.com/how-to-read-research-papers-a-pragmatic-approach-for-ml-practitioners-299935624326

如何理解人工智能/人工智能研究出版物

斯科特·格雷厄姆在 Unsplash 上拍照

数据科学家或机器学习专家有必要阅读研究论文吗?

简单的回答是肯定的。如果你缺乏正式的学术背景或只获得了机器学习领域的本科学位,也不用担心。

对于没有广泛教育背景的人来说,阅读学术研究论文可能会令人生畏。然而,缺乏学术阅读经验不应阻止数据科学家利用宝贵的信息和知识来源进行机器学习和人工智能开发。

本文为任何技能水平的数据科学家提供了阅读学术期刊上发表的研究论文的实践指南,如 NeurIPS 、 JMLR 、 ICML、等。

在全心投入阅读研究论文之前,学习如何阅读研究论文的第一阶段包括选择相关主题和研究论文。

第一步:确定主题

机器学习和数据科学领域是许多学科领域的家园。但这并不一定意味着处理机器学习中的每个主题都是最佳选择。

虽然建议入门级从业者一般化,但我猜测,当涉及长期机器学习时,职业前景、从业者和行业兴趣通常会转移到专业化。

确定一个合适的主题可能很难,但是很好。不过,一个经验法则是选择一个你有兴趣获得专业职位或者已经有经验的 ML 领域。

深度学习是我的兴趣之一,我是一名计算机视觉工程师,在应用程序中使用深度学习模型来专业解决计算机视觉问题。因此,我对姿势估计、动作分类和手势识别等主题感兴趣。

基于角色,以下是 ML/DS 职业和相关主题的例子。

图 1:机器学习和数据科学的角色和相关主题。作者创建的图像

对于这篇文章,我将选择姿势估计这个主题进行探索,并选择相关的研究论文进行研究。

第二步:寻找研究论文

在查看机器学习相关的研究论文、数据集、代码和其他相关材料时,最优秀的工具之一是代码为的 PapersWithCode 。

我们使用 PapersWithCode 网站上的搜索引擎来获取我们所选主题“姿态估计”的相关研究论文和内容下图向您展示了这是如何做到的。

图 2:作者创建的图片:GIF 搜索姿势估计

搜索结果页面包含对搜索主题的简短说明,随后是相关数据集、模型、论文和代码的表格。不涉及太多的细节,这个用例感兴趣的领域是“有代码的最伟大的论文”。这部分包含与任务或主题相关的论文。对于本文,我将选择密集姿势:野外密集人体姿势估计。

第三步:第一遍(获得背景和理解)

照片由absolute vision上Unsplash

此时,我们已经选择了一篇研究论文进行研究,并准备从其内容中提取任何有价值的知识和发现。

很自然,你的第一个冲动是开始写笔记并从头到尾阅读文档,也许在中间休息一下。然而,有一个研究论文内容的背景是一个更实用的阅读方法。标题、摘要和结论是理解任何研究论文的三个关键部分。

你所选论文的第一遍的目标是达到以下目标:

- 确保论文是相关的。

- 通过学习文章的内容、方法和发现,获得对文章内容的理解。

- 认可作者的目标、方法和成就。

标题

标题是作者和读者分享信息的第一点。因此,研究论文的标题是直接的,以一种不留任何歧义的方式构成。

研究论文的标题是最能说明问题的方面,因为它表明了这项研究与你的工作的相关性。标题的重要性在于简要介绍论文的内容。

在这种情况下,标题是“密集姿势:野外密集人体姿势估计”这给出了工作的广泛概述,并意味着它将着眼于如何在高活动水平和现实情况的环境中适当地提供姿态估计。

摘要

摘要部分给出了论文的摘要版本。这是一个很短的部分,包含 300-500 个单词,简单地告诉你论文的内容。摘要是一个简短的文本,概述了文章的内容,研究人员的目标,方法和技术。

当阅读机器学习研究论文的摘要时,你通常会遇到数据集、方法、算法和其他术语的提及。与文章内容相关的关键词提供了上下文。做笔记并跟踪所有关键词可能会有所帮助。

对于这篇文章:“Dense Pose:Dense person Pose Estimation In The Wild”,我在摘要中确定了以下关键词:姿势估计、COCO 数据集、CNN、基于区域的模型、实时。

结论

当你第一次从头到尾阅读论文时,疲劳是很常见的,特别是对于没有高级学术经验的数据科学家和从业者。虽然在长时间的学习后,从论文的后面部分提取信息可能会显得乏味,但结论部分通常很短。因此,建议在第一遍阅读结论部分。

结论部分简要概述了作品的作者或作者和/或贡献和成就,以及对未来发展和局限性的承诺。

在阅读研究论文的主要内容之前,先阅读结论部分,看看研究人员的贡献、问题领域和成果是否符合你的需求。

遵循这一特定的简短的第一步,可以充分理解和概述研究论文的范围和目标,以及其内容的背景。如果你全神贯注地再看一遍,就能从内容中获得更详细的信息。

第四步:第二遍(内容熟悉)

熟悉内容是一个与初始步骤相关的过程。熟悉过程是一个步骤,涉及研究论文中的引言部分和图表。

如前所述,不需要直接进入研究论文的核心,因为知识适应在以后的过程中提供了更详细和更全面的研究检查。

介绍

研究论文的介绍部分是为了提供研究工作目标的概述。这个目标提到并解释了问题领域、研究范围、先前的研究成果和方法。

使用相似或不同的方法,在这一领域找到与过去研究工作的相似之处是很正常的。其他论文的引用提供了问题领域的范围和广度,为读者拓宽了探索区域。在这一点上,也许合并步骤 3 中概述的过程就足够了。

引言部分提供的好处的另一个方面是介绍处理和理解研究论文内容所需的必要知识。

图表、图解和数字

研究论文中的说明性材料确保读者能够理解支持问题定义的因素或所提出方法的解释。通常,研究论文中使用表格来提供新技术与类似方法相比的定量性能信息。

显示 DensePose 与其他单人姿势估计解决方案比较的图像。

一般来说,数据和性能的可视化表示使得能够对论文的上下文有直观的理解。在前面提到的密集姿态论文中,插图描述了作者的姿态估计方法的性能。

在深度学习领域,经常可以找到描述人工神经网络结构的拓扑插图。这又增加了对任何读者的直观理解。通过插图和数字,读者可以自己解释信息并获得更全面的视角,而不会对结果有任何先入为主的概念。

图片显示了 DensePose 的交叉级联架构。

第五步:第三遍(深度阅读)

论文的第三遍与第二遍相似,尽管它覆盖了更重要的部分。关于这一关最重要的事情是你避免任何复杂的算术或技术公式,这可能对你来说是困难的。在此过程中,你也可以跳过任何你不理解或不熟悉的单词和定义。这些不熟悉的术语、算法或技术应该注意,以便稍后返回。

照片由Markus Winkler上的Unsplash。

在这一阶段,你的主要目标是对论文内容有一个大致的了解。接近论文,再次从摘要开始到结论,但是一定要在各部分之间有中间休息。此外,建议准备一个记事本,在上面记录所有重要的见解和要点,以及不熟悉的术语和概念。

番茄工作法是管理深度阅读或学习时间的有效方法。据解释,番茄工作法包括将一天分成几个工作块,然后是短暂的休息。

对我有用的是 50/15 的分配,即 50 分钟学习,15 分钟休息。我倾向于在休息 30 分钟之前连续做两次这种分割。如果你不熟悉这种时间管理技巧,可以采用相对简单的划分方法,比如 25/5,并根据你的关注点和时间容量来调整时间划分。

第六步:第四遍(最后一遍)

最后一关通常涉及到运用你的思维和学习能力,因为它涉及到浏览前一关中提到的不熟悉的术语、术语、概念和算法。这一关着重于使用外部材料来理解论文中记录的不熟悉的方面。

对不熟悉的主题进行深入研究没有特定的时间长度,有时努力会持续几天甚至几周。成功完成最后一次勘探的关键因素是找到合适的勘探源。

不幸的是,互联网上没有一个来源能提供你所需要的大量信息。尽管如此,有多种来源,当统一和适当地使用时,可以填补知识空白。下面是其中的一些资源。

- 机器学习子编辑

- 深度学习子编辑

- 纸张代码

- 顶级会议如 NIPS , ICML , ICLR

- 研究门

- 机器学习苹果

研究论文的参考部分提到了技术和算法。因此,目前的论文要么是从参考文献中获得灵感,要么是建立在参考文献的基础上,这就是为什么参考文献是你在深度阅读课程中使用的一个有价值的来源。

第 7 步:总结(可选)

在近十年的与技术相关的学科和角色的学术和专业工作中,最有效的方法是通过重述探索的主题来确保任何新学到的信息保留在我的长期记忆中。通过用我自己的话重写新的信息,无论是书面的还是打字的,我能够以可理解的方式和令人难忘的方式来强化已提出的观点。

照片由neon brand上Unsplash

更进一步说,可以通过利用博客平台和社交媒体来宣传学习成果和笔记。假设读者不习惯这个话题或主题,试图向广大读者解释这个新探索的概念,需要理解话题内在的细节。

结论

毫无疑问,对于新手数据科学家和 ML 从业者来说,阅读研究论文可能会令人生畏,具有挑战性;即使是经验丰富的从业者也很难一次成功消化研究论文的内容。

数据科学职业的本质是非常实际和复杂的。这意味着,它的从业者需要采用学术思维,尤其是数据科学领域与人工智能密切相关,而人工智能仍是一个发展中的领域。

总而言之,下面是你阅读研究论文应该遵循的所有步骤

- 确定一个主题。

- 查找相关研究论文

- 阅读标题、摘要和结论,对研究的目标和成果有一个模糊的理解。

- 通过深入研究介绍来熟悉内容,包括研究论文中的数字和图表。

- 当你从上到下阅读文章时,使用深度阅读来消化文章的主要内容。

- 利用外部资源探索不熟悉的术语、术语、概念和方法。

- 用你自己的话总结基本要点、定义和算法。

感谢阅读。

本文最初发表于 Nvidia 开发者博客

我希望这篇文章对你有所帮助。

要联系我或找到更多类似本文的内容,请执行以下操作:

- 成为推荐媒介会员,支持我的写作

- 订阅我的 电子邮件列表 获取我的简讯

- 通过 LinkedIn 联系我

- 在 Twitter 上获取我的实时更新

如何使用 FastAPI 通过 HTTP 从/向 SQL 读取/写入数据帧

原文:https://towardsdatascience.com/how-to-read-write-dataframes-from-to-sql-over-http-with-fastapi-e48ab91e6a83

不到 10 分钟

照片感谢来自 Unsplash 的 growtika 。

在工业中处理数据是一件痛苦的事情。这是因为数据可以分散在多个项目中,以不同的格式存储,并以不同的程度维护。通常,这导致不同的团队开发不同的内部工具来处理他们的数据。由于没有标准的读写数据的方法,整个事情变得一团糟。

一个解决方案是开发数据摄取微服务。本质上,这些应用程序支持通过 HTTP 或 RPC 调用进行数据传输。他们试图提供一种统一的格式来读取和写入不同的数据源(例如 Google BigQuery、Postgres 等)。这个想法是,其他应用程序(比如仪表板)将使用数据摄取应用程序来加载数据。下图描述了一个简单的用例:

在本教程中,我将描述开发一个简单的数据摄取应用程序的过程,该应用程序使用 FastAPI 读取和写入任何 Postgres 数据库。

应用端点

摄取数据

接收端点将用于读取数据。为此,我们需要连接到数据库的参数。这些将是 db_user 、 db_password 、 db_port 、 db_name 和 db_host 。我们还需要一种查询数据库的方法,在这种情况下,它可以只是一个字符串 sql_query 。

我们使用fastapi定义我们的应用程序,并开始构建端点:

from fastapi import FastAPI

from pydantic import BaseModel# initialise app

app = FastAPI()

# pydantic class for collecting our parameters into a json object

class IngestionParams(BaseModel):sql_query: strusername: strpassword: strport: inthost: strdatabase_name: str

# define POST endpoint "ingest"

@app.post("/ingest")

def ingest(ingestion_params: IngestionParams

):# retrieve ingestion params as dictionaryingestion_params = ingestion_params.dict()db_user = ingestion_params['username']db_password = ingestion_params['password']db_host = ingestion_params['host']db_port = ingestion_params['port']db_name = ingestion_params['database_name']sql_query = ingestion_params['sql_query']

**重要提示:**根据 REST API 设计模式,在 get 和 post 请求之间应该有所区别。通常, get 用于读取数据, post 用于发送数据。然而,在这种情况下,最好使用 post 来获取,因为:1)浏览器日志通常包含 URL 历史记录(这意味着敏感参数(如 DB 凭证)会被暴露),2)URL 长度有限制[ 1 ]

现在,我们需要连接到我们的客户机并执行查询。为此,我们可以使用sqlalchemy:

import sqlalchemy as db

import pandas as pd# connect to db

db_uri = f'postgresql+psycopg2://{db_user}:{db_password}@{db_host}:{db_port}/{db_name}'

engine = db.create_engine(db_uri)

con = engine.connect()

# query db

query_result = con.execute(sql_query)

data = query_result.fetchall()

# convert to dataframe

columns = query_result.keys()

df = pd.DataFrame(data, columns=columns)

剩下的最后一件事是我们如何通过 HTTP 请求发送回数据帧。有多种方法可以做到这一点,但是为了保留 dtype,我们将 DataFrame 转换为一个 Parquet 文件,并使用内容类型application/octer-stream将其作为二进制文件发送。

# added import

from fastapi import Response

def ingest(response: Response, # add response parameteringestion_params: IngestionParams

)...

# return parquet file in Response object

return Response(df.to_parquet(engine='pyarrow', index=False), media_type='application/octet-stream')

插入数据

为了插入数据,我们需要和以前一样的参数来连接数据库。然而,我们还需要 table_name 、 dataset_name 和conflict _ resolution _ strategy。

我们还需要一个文件参数来发送数据。这样,我们开始设计插入端点:

from fastapi import File, UploadFile

from pydantic import Json

# pydantic class for collecting our parameters into a json object

class InsertionParams(BaseModel):username: strpassword: strport: int = 5432host: strdatabase_name: strtable_name: strconflict_resolution_strategy: str = 'replace' # default value# define POST endpoint "insert" using async

@app.post("/insert")

async def insert(response: Response, # for returning the dataframe that we insertinsertion_params: Json[InsertionParams],file: UploadFile = File(...)

):# retrieve insertion params as dictionaryinsertion_params = insertion_params.dict()db_user = insertion_params['username']db_password = insertion_params['password']db_host = insertion_params['host']db_port = insertion_params['port']db_name = insertion_params['database_name']table_name = insertion_params['table_name']conflict_resolution_strategy = insertion_params['conflict_resolution_strategy']dataset_name = insertion_params.get('dataset_name', None)content = await file.read()

现在,我们想要设计我们的 API 来支持不同的文件类型作为输入。我们可以使用 file 对象的 content_type 属性来确定文件类型,然后适当地读取它。

import io

with io.BytesIO(content) as data:if 'csv' in file.content_type:df = pd.read_csv(data)if file.content_type == 'text/tab-separated-values':df = pd.read_csv(data, delimiter='\t')if file.content_type == 'application/octet-stream': # TODO can you have other 'octet-stream'?df = pd.read_parquet(data, engine='pyarrow')

与之前类似,我们通过初始化客户端连接到数据库,然后使用来自pandas的.to_sql方法写入 postgres。但是,我们必须确保在使用该方法时传递数据类型,否则您的表将会被不正确地填充。因此:

# import types

from sqlalchemy import INTEGER, FLOAT, TIMESTAMP, VARCHAR, BOOLEAN

from pandas.api.types import is_datetime64tz_dtype

# connect to database

...

DTYPE_MAP = {'int64': INTEGER,'float64': FLOAT,'datetime64[ns]': TIMESTAMP,'datetime64[ns, UTC]': TIMESTAMP(timezone=True),'bool': BOOLEAN,'object': VARCHAR}

def _get_pg_datatypes(df):dtypes = {}for col, dtype in df.dtypes.items():if is_datetime64tz_dtype(dtype):dtypes[col] = DTYPE_MAP['datetime64[ns, UTC]']else:dtypes[col] = DTYPE_MAP[str(dtype)]return dtypes

dtypes = _get_pg_datatypes(df)

df.to_sql(table_name, con, schema=dataset_name, if_exists=conflict_resolution_strategy, index=False, method='multi', dtype=dtypes)

response.status_code = 201

return "Created table"

运行应用程序

总的来说,代码应该如下所示:

from fastapi import FastAPI, Response, File, UploadFile

from pydantic import BaseModel, Json

import sqlalchemy as db

import pandas as pd

import io

from sqlalchemy import INTEGER, FLOAT, TIMESTAMP, VARCHAR, BOOLEAN

from pandas.api.types import is_datetime64tz_dtype

# initialise app

app = FastAPI()

# pydantic class for collecting our parameters into a json object

class IngestionParams(BaseModel):sql_query: strusername: strpassword: strport: inthost: strdatabase_name: str

class InsertionParams(BaseModel):username: strpassword: strport: int = 5432host: strdatabase_name: strtable_name: strconflict_resolution_strategy: str = 'replace' # default value

def _connect_to_db(user, password, host, port, name):db_uri = f'postgresql+psycopg2://{user}:{password}@{host}:{port}/{name}'engine = db.create_engine(db_uri)con = engine.connect()return con

# define POST endpoint "ingest"

@app.post("/ingest")

def ingest(response: Response,ingestion_params: IngestionParams

):# retrieve ingestion params as dictionaryingestion_params = ingestion_params.dict()db_user = ingestion_params['username']db_password = ingestion_params['password']db_host = ingestion_params['host']db_port = ingestion_params['port']db_name = ingestion_params['database_name']sql_query = ingestion_params['sql_query']# connect to dbcon = _connect_to_db(db_user, db_password, db_host, db_port, db_name)# query dbquery_result = con.execute(sql_query)data = query_result.fetchall()# convert to dataframecolumns = query_result.keys()df = pd.DataFrame(data, columns=columns)# return parquet file in Response objectreturn Response(df.to_parquet(engine='pyarrow', index=False), media_type='application/octet-stream')# define POST endpoint "insert" using async

@app.post("/insert")

async def insert(response: Response, # for returning the dataframe that we insertinsertion_params: Json[InsertionParams],file: UploadFile = File(...)

):# retrieve insertion params as dictionaryinsertion_params = insertion_params.dict()db_user = insertion_params['username']db_password = insertion_params['password']db_host = insertion_params['host']db_port = insertion_params['port']db_name = insertion_params['database_name']table_name = insertion_params['table_name']conflict_resolution_strategy = insertion_params['conflict_resolution_strategy']dataset_name = insertion_params.get('dataset_name', None)content = await file.read()with io.BytesIO(content) as data:if 'csv' in file.content_type:df = pd.read_csv(data)if file.content_type == 'text/tab-separated-values':df = pd.read_csv(data, delimiter='\t')if file.content_type == 'application/octet-stream': # TODO can you have other 'octet-stream'?df = pd.read_parquet(data, engine='pyarrow')DTYPE_MAP = {'int64': INTEGER,'float64': FLOAT,'datetime64[ns]': TIMESTAMP,'datetime64[ns, UTC]': TIMESTAMP(timezone=True),'bool': BOOLEAN,'object': VARCHAR}def _get_pg_datatypes(df):dtypes = {}for col, dtype in df.dtypes.items():if is_datetime64tz_dtype(dtype):dtypes[col] = DTYPE_MAP['datetime64[ns, UTC]']else:dtypes[col] = DTYPE_MAP[str(dtype)]return dtypesdtypes = _get_pg_datatypes(df)# connect to dbcon = _connect_to_db(db_user, db_password, db_host, db_port, db_name)df.to_sql(table_name, con, schema=dataset_name, if_exists=conflict_resolution_strategy, index=False, method='multi', dtype=dtypes)response.status_code = 201return "Created table"

请注意,我们已经清理了一些东西!

我们可以将其保存到一个名为main.py的文件中,然后在终端中运行以下命令:

uvicorn main:app --reload

现在,您应该可以通过访问以下 url 在浏览器中看到该应用程序:

localhost:8000/docs

这是您应该在 localhost:8000/docs 上看到的内容

设置

为了测试我们的应用程序是否正常工作,我们需要一个 postgres 实例来测试。出于本文的目的,我们将使用 Docker Postgres 实例(尽管您可以随意使用)。

为此,您需要安装 docker。然后,您可以在终端中运行以下命令:

docker run -p 5432:5432 -e POSTGRES_PASSWORD=postgres -d postgres

您现在应该有一个本地运行的 postgres 实例,并在 5432 端口上有一个连接。您可以使用数据库查看软件来查看。在我的例子中,我使用 DBeaver [ 2 ]。

数据库的连接参数是:

- 用户名: postgres

- **主机:**本地主机

- 港口: 5432

- 密码: postgres

- 数据库名称: postgres

使用请求读取文件

使用 UI 来读/写数据是相对直观的。当您想从 Python 内部调用端点时,这就不那么重要了。为此,我们使用requests模块。

import io

import pandas as pd

import requests

BASE_URL = 'http://localhost:8000' # url for app comprised of host and port

# headers for request

headers = {'Content-Type': 'application/json','Accept': 'application/octet-stream'

}

# function for validating successful request

def _is_status_code_valid(status_code):if str(status_code).startswith('2'):return True

def read_data(ingestion_param,

):#url = f'{BASE_URL}/ingest'resp = requests.post(url, json=ingestion_param, headers=headers)status_code = resp.status_codeif _is_status_code_valid(status_code):df = pd.read_parquet(io.BytesIO(resp.content), engine='pyarrow')return df, status_code

上面的关键方面是,我们以字节为单位读取响应,但我们需要数据作为数据帧。因此,在将响应内容作为 parquet 读取之前,我们将它转换为 BytesIO 对象。我们保存 dtype,因为 parquet 文件包含表 dtype 信息。

使用请求发送文件

发送文件比阅读文件稍微复杂一些。这是因为 post 请求的请求参数并不简单,我们必须想办法将数据帧转换成可接受的格式。

import io

import json

import requestsBASE_URL = 'http://localhost:8000' # url for app comprised of host and port

def write_data(database_name,table_name,database_type='pg',df=pd.DataFrame(),content_type='csv',conflict_resolution_strategy='fail',username='postgres',password='postgres',port=5432,host='localhost',):url = f'{BASE_URL}/insert'# in principle, it is possible to add converters for any content_typeif content_type == 'parquet':memory_buffer = io.BytesIO()df.to_parquet(memory_buffer,engine='pyarrow')memory_buffer.seek(0)# need to encode parameters as json stringdata = {'insertion_params': json.dumps(dict(username=username,password=password,port=port,database_name=database_name,table_name=table_name,conflict_resolution_strategy=conflict_resolution_strategy,host=host))}# need to send files separatelyfiles = {'file': ('Test', memory_buffer, 'application/octet-stream')}resp = requests.post(url, data=data, files=files)return resp.text, resp.status_code

结束语

在本文中,我们使用 FastAPI for Postgres 设计了一个数据摄取应用程序。以下是关键要点的快速总结:

- 数据摄取应用程序比在单独的项目中构建摄取功能更可取,因为它是标准化的,更易于维护,并能适应变化

- 将数据帧转换成 Parquet 对于通过 HTTP 发送它们很有用,因为我们保留了数据类型信息

- 目前的应用程序可以很容易地扩展到支持其他数据源,如 BigQuery,Google Drive 等…

限制

- 仅支持 postgres

- 目前,使用

.to_sql的方法不支持上插功能

本文使用的全部代码可以在下面的存储库中找到:https://github.com/namiyousef/in-n-out。

引用表

[1]https://stack overflow . com/questions/19637459/rest-API-using-post-inst-of-get

[2]https://dbeaver.io/

以上所有图片和代码均为作者所有,除非另有说明

如何在手机上接收机器学习模型训练完成时间通知

原文:https://towardsdatascience.com/how-to-receive-machine-learning-model-training-completion-time-notifications-on-your-phone-a8e6cdb02d1a

一种在 Python 脚本中单击“运行”并离开直到模型训练完成的方法。

- 注意:我与 aporia 和 mlnotify 的创建者没有任何关系。我只是分享这一点,以帮助其他人的数据科学学习经验。

照片由 Aron 视觉效果在 Unsplash 上拍摄

介绍

每个人在他们的数据科学旅程中都要经历这个过程:w 等待他们的机器学习模型训练完成。你是干什么的?你会坐在电脑前等待模型完成吗?或者你离开了,冒着训练过程提前结束的风险,或者浪费宝贵的时间,认为你的模型实际上已经完成了,还在训练?我找到了一种方法来训练你的机器学习模型,离开你的电脑,当训练完成时,会收到通知。如果你生活中有其他的事情要做,需要离开电脑,但又不想在模型训练结束后浪费宝贵的分析时间,这将非常有帮助。

mlnotify

我最近在我的数据科学之旅中遇到了 mlnotify ,认为它好得令人难以置信。你可以在这里找到更多关于ml notify的信息。它是由 aporia 创建的,是一个在模型训练完成时通知机器学习爱好者的工具。用户调用后。fit() 在他们的 ML 模型上,提供了一个二维码,用户可以对其拍照并接收计时器,并在他们的手机上更新训练的完成情况。此外,用户可以选择访问 mlnotify 网站来跟踪其模型的训练进度,也可以选择在训练停止时接收电子邮件。

例子

在今天的例子中,我们将创建一个基本的卷积神经网络(CNN )来对 MNIST 数据集进行分类。首先,我们想要导入我们的包。

import mlnotify

import tensorflow as tf

import keras

import numpy as np

from keras import layers

你将需要!pip 在导入库之前安装 mlnotify。接下来,我们要加载 MNIST 数据集。 Keras API 允许我们用他们的数据集方法来做这件事。为了正确训练我们的模型,我们需要在 0 和 1 之间缩放图像,将它们转换为 float32 值,并将其整形为 *(28,28,1)。*最后一步是将类别标签向量转换成二进制矩阵。

#Creating the training and test sets(x_train, y_train), (x_test, y_test) = keras.datasets.mnist.load_data()#Image scaling

x_train = x_train.astype("float32") / 255

x_test = x_test.astype("float32") / 255# Image Shaping

x_train = np.expand_dims(x_train, -1)

x_test = np.expand_dims(x_test, -1)#Class label vector conversion

num_class = 10

y_train = keras.utils.to_categorical(y_train, num_class)

y_test = keras.utils.to_categorical(y_test, num_class)

现在让我们创建模型。该模型将有两个卷积层,每个使用 3x3 内核和一个泄漏 ReLU (LReLU)激活函数。第一卷积层将具有 32 个神经元,第二层将成形为具有 64 。在卷积层之后,我们将使用参数值为 (2,2)的最大池层。最后,该模型将以一个脱落层、展平层和密集层结束,该层使用我们为其神经元数量创建的 num_class 参数(在本例中为 10 )。密集层将利用 Softmax 激活功能,因为这是一个多分类问题。

model = keras.Sequential([

keras.Input(shape=input_shape),

layers.Conv2D(32, kernel_size=(3, 3)),

layers.LeakyReLU(),

layers.MaxPooling2D(pool_size=(2, 2)),

layers.Conv2D(64, kernel_size=(3, 3)),

layers.LeakyReLU(),

layers.MaxPooling2D(pool_size=(2, 2)),

layers.Flatten(),

layers.Dropout(0.5),

layers.Dense(num_classes, activation="softmax"),

]

)

最后是训练模式的时候了。让我们看看 mlnotify 如何与培训过程交互。您需要编写 %%notify 和 mlnotify.start() (参考下面的代码)来调用 mlnotify API。

%%notify

mlnotify.start()

batch_size = 128

epochs = 10model.compile(loss="categorical_crossentropy", optimizer="adam", metrics=["accuracy"])model.fit(x_train, y_train, batch_size=batch_size, epochs=epochs, validation_split=0.1)

当您执行他的代码时,会弹出一个二维码,让您可以在手机上获得培训进度。

培训二维码(图片来自作者)

扫描二维码后,你的手机上会弹出一个计时器来跟踪你的模特的训练。

电话计时器培训(图片来自作者)

你也可以通过 mlnotify 提供的链接访问同一个定时器。一旦培训完成, mlnotify 将会通过电话通知您,无论您身在何处!

培训完成(图片来自作者)

结论

正如我们今天看到的,当你离开办公桌而不是坐在电脑前盯着进度条的时候,有一些方法可以通知你机器学习模型何时完成训练*。这个 API 允许你在终端中点击 run,继续做你一天中的其他事情,而不必经常检查模型的训练进度。我发现这个 API 在训练耗时较长的模型时非常有用。它允许我去做我一天中喜欢和享受的其他活动,但通过 mlnotify 的快速通知快速返回我训练的模型的结果。我希望你和我一样在使用这个工具时发现同样的价值!*

如果你喜欢今天的阅读,请关注我,并告诉我你是否还有其他想让我探讨的话题!如果你没有中等账号,就通过我的链接 这里 报名吧!另外,在LinkedIn上加我,或者随时联系!感谢阅读!

如何为您的 Azure 数据湖构建时间点恢复解决方案

原文:https://towardsdatascience.com/how-to-recover-your-azure-data-lake-5b5e53f3736f

利用快照、软删除和 Azure 功能在 Azure 数据湖存储上构建时间点恢复解决方案。

TLTR:在 克隆项目并运行脚本 https://github . com/rebremer/azure-functions-data lake-recovery-pitr/blob/main/script . PS1部署解决方案

1.介绍

企业数据湖中的一个普遍担忧是,由于应用程序错误或人为错误,数据会被破坏。在这种情况下,可能需要执行时间点恢复(PiTR)并恢复快照。启用了分层命名空间(HNS)的 Azure 存储尚不支持 PiTR。但是,快照和软删除是可用的,可以用作创建恢复解决方案的构造块。

在这篇博客和 git repo [azure-functions-datalake-recovery-pitr](https://github.com/rebremer/azure-functions-datalake-recovery-pitr)中,讨论了如何使用快照、软删除和 Azure 函数来实现 PiTR,参见下面的架构。

1.建筑——作者的图像

在这篇博文的剩余部分,我们将更详细地解释数据湖恢复项目。这将按如下方式完成:

- 在第 2 章中,确保在数据湖中添加/修改文件时创建快照。

- 在第 3 章中,详细解释了如何使用这些快照来构建数据湖恢复功能,以便在数据损坏时加以利用。此外,解决方案的可扩展性将在第 3.3 章中讨论。

最后,要了解更多关于灾难恢复的知识,请参阅我之前的博客。

2.基于事件:创建快照

在这一章中,项目开始运行。在这方面,需要做以下工作:

- 2.1 先决条件

- 2.2 设置 Azure 数据湖

- 2.3 设置快照创建

另请参见下面的概述:

2.架构,基于事件的快照创建—按作者创建图像

2.1 先决条件

本教程需要以下先决条件:

- Azure CLI

- Python 3.7+

- Azure 功能核心工具

最后,将下面的 git repo 克隆到您的本地计算机上。如果你没有安装 git,你可以从网页上下载一个 zip 文件。

git clone [https://github.com/rebremer/azure-functions-datalake-recovery-pitr](https://github.com/rebremer/azure-functions-datalake-recovery-pitr)

2.2 设置 Azure 数据湖

在这一部分中,使用以下属性创建了一个 Azure 数据湖

- 支持分层命名空间(HNS)的 Azure 存储帐户提供了真正的文件系统,而不是基于对象的存储

- 为启用了 HNS 的存储帐户启用快照预览,请参见https://learn . Microsoft . com/en-us/azure/storage/blob/snapshot s-overview # about-blob-snapshot s

- 已禁用访问密钥,仅允许 Azure AD 作为身份外围设备

- 启用软删除

运行以下脚本:

# 0\. Set variables

#

$SUB='<<your subscription>>'

$RG='<<your resource group>>'

$LOC='<<your location>>'

$DLSTOR='<<your data lake account>>'

$FILE_SYSTEM='<<your data lake file system name>>'

$EMAIL='<<your email address>>' # 1\. Create resource group

#

az account set --subscription $SUB

az group create -n $RG -l $LOC# 2\. Create data lake account

#

az storage account create -n $DLSTOR -g $RG -l $LOC --sku Standard_LRS --kind StorageV2 --enable-hierarchical-namespace true --allow-shared-key-access false# 3\. Add yourself as user to data lake acount

#

$scope="/subscriptions/$SUB/resourceGroups/$RG/providers/Microsoft.Storage/storageAccounts/$DLSTOR/blobServices/default"

az role assignment create --role "Storage Blob Data Contributor" --assignee $email --scope $scope # 4\. Enable soft delete on storage acount

#

az storage account blob-service-properties update -n $DLSTOR -g $RG --enable-delete-retention true --delete-retention-days 7# 5\. Create File System on date lake account

#

az storage container create --account-name $DLSTOR -n $FILE_SYSTEM --auth-mode login

2.3 设置快照创建

在这一部分中,一旦创建或更新了文件,就会创建快照。这是按如下方式完成的:

- 创建侦听存储帐户的事件网格

- 一旦文件被创建/修改,事件网格 Azure Functions 被触发

- Azure Functions 创建文件快照

另请参见下面的脚本:

# 0\. Set variables

#

$SUB='<<your subscription>>'

$RG='<<your resource group>>'

$LOC='<<your location>>'

$DLSTOR='<<your data lake account>>'

$FUNSTOR='<<your azure function storage account>>'

$FUNNAME='<<your azure function name>>'

$FUNPN='<<your azure function app plan name>>'# 1\. Deploy Event Grid triggered Functions

#

az functionapp plan create -g $RG -n $FUNPN --sku B1 --is-linux true

az storage account create -n $FUNSTOR -g $RG -l $LOC --sku Standard_LRS --kind StorageV2

az functionapp create -n $FUNNAME -g $RG -s $FUNSTOR -p $FUNPN --assign-identity --runtime Python

$function_mi=$(az functionapp show -n $FUNNAME -g $RG | ConvertFrom-Json).identity.principalId

az role assignment create --assignee $function_mi --role "Storage Blob Data Contributor" --scope $scope

func azure functionapp publish $FUNNAME # 2\. Subscribe to event grid

#

$stordlid = "/subscriptions/$SUB/resourceGroups/$RG/providers/Microsoft.Storage/storageaccounts/$DLSTOR"

$endpointid = "/subscriptions/$SUB/resourceGroups/$RG/providers/Microsoft.Web/sites/$FUNNAME/functions/EventGridTriggerCreateSnapshot"

az eventgrid event-subscription create --name storegversion --source-resource-id $stordlid --endpoint-type azurefunction --endpoint $endpointid --included-event-types Microsoft.Storage.BlobCreated

如果现在文件被上传到存储帐户或被修改,则会自动创建快照,另请参见下图。

2.3 自动快照创建—按作者创建图像

在下一章中,我们将讨论 Azure 函数,它可以用来恢复快照。

3.发生灾难时:恢复数据湖

在这一章中,数据湖将在灾难发生时恢复。在这方面,需要做以下工作:

- 3.1 讨论灾难恢复场景

- 3.2 设置和运行 Azure 持久功能

- 3.3 规模数据湖恢复解决方案

另请参见下面的概述:

3.1 讨论灾难恢复场景

当数据损坏发生时,您希望恢复数据损坏前的状态。让我们把这个时刻命名为 restore_date。那么对于每个单独的文件,下面的场景是真实的

- 场景 1: file_last_modified < restore_date. In this situation, the file was last modified before corruption occured ⇒什么都不做

- 场景 2:文件创建时间>恢复日期。在这种情况下,文件仅在发生损坏后创建= >软删除文件

- 场景 3:文件创建时间< restore_date < file_last_modified && snapshot is present before restore_date ⇒恢复快照

- 场景 4: file_creation_time < restore_date < file_last_modified && NO_snapshot is present before restore_date ⇒提出条件,创建需要更多调查的警报下一步做什么

请注意,当实现第 2 章中解释的基于事件的快照时,场景 4 永远不会发生;每当创建或修改文件时,都会创建快照。4 个场景的详细逻辑可以在下面的 Python 文件中找到:[ActivityPointInTimeRecovery](https://github.com/rebremer/azure-functions-datalake-recovery-pitr/blob/main/ActivityPointInTimeRecovery/__init__.py#L91)

3.2 安装和 Azure 持久功能

通常,企业数据湖包含数百个容器、数百个文件夹和子文件夹以及数 TB 的数据。要恢复数据湖,以下是关键:

- 恢复数据湖应该是精细的。应该可以恢复单个容器,甚至文件夹,而不是整个存储帐户

- 修复应在大范围内进行。这应该并行进行,而不是让一个进程一个接一个地恢复文件夹和文件

Azure 持久功能扇入/扇出模式正是这么做的。在这个场景中,多个函数被并发执行,文件夹被递归解析。

在下面的脚本中,代码被部署到一个 Azure 函数。也可以决定先在本地运行 Azure(见脚本此处)。运行以下脚本以部署到 Azure 功能:

# 0\. Set variables

#

$RG='<<your resource group>>'

$DLSTOR='<<your data lake account>>'

$FILE_SYSTEM='<<your data lake file system name>>'

$FUNNAME='<<your azure function name>>'# 1\. Deploy Function

#

func azure functionapp publish $FUNNAME# 2\. Get function key

#

$code=$(az functionapp keys list -n $FUNNAME -g $RG | ConvertFrom-Json).functionKeys.default# 3\. Create sample folders and files in File System

#

Invoke-RestMethod "https://$FUNNAME.azurewebsites.net/api/orchestrators/OrchestratorInitFileSystem?code=$code&storage_account_name=$DLSTOR&file_system=$FILE_SYSTEM&number_of_folders=2"# 4\. Restore data lake (play around with restore_date in URL to test # four scenarios described in 2.2

#

Invoke-RestMethod "https://$FUNNAME.azurewebsites.net/api/orchestrators/OrchestratorPointInTimeRecovery?code=$code&restore_date=2021-01-20T00:00:00.0000000Z&storage_account_name=$DLSTOR&file_system=$FILE_SYSTEM&number_of_folders=2"

脚本成功运行后,一个包含 2 个文件夹和 100 个子文件夹的文件系统被设置,每个子文件夹包含 10 个文件,另请参见下面的屏幕截图:

3.2.1 目录 1,子目录 12,包含 10 个文件

使用快照,可以选择任何日期来恢复快照。逻辑描述了将恢复哪些快照(如果有),请参见下面示例文件中可以恢复的可能快照:

3.2.2 目录、子目录 12、文件测试快照 5.txt、要恢复的可能快照

3.3 规模数据湖恢复解决方案

选择 Azure 持久功能是因为它的伸缩能力。在上一章中,创建了一个只有两个文件夹的 file_system。通过改变 InitFileSystem 函数中的参数&number_of_folders=10000,可以建立一个 10M(10000 * 100 * 10)文件的文件夹结构。但是,在执行此操作之前,该解决方案应进行扩展,因为基本 SKU 仅用于 1 名员工。有两种选择两种规模。

- 纵向扩展:通过纵向扩展,可以使用拥有更多内核/内存的虚拟机。通过使用更多的内核和内存,可以在同一台机器上运行多个恢复线程。最高的 SKU 是 P3V3 ,其中使用了 8 个内核(相比之下,3.2 中使用的基本 SKU 只有一个内核)

- 横向扩展:通过横向扩展,多个虚拟机/工作人员用于运行恢复作业。如果使用 2 个内核的 P1V3 SKU,虚拟机的最大数量为 30,另请参见下图

3.3 SKU P1 v3 中的横向扩展解决方案最多 30 个实例(工作人员)

通过横向扩展,该解决方案可以真正扩展到在几分钟/几小时内恢复 1000 万个文件。最后,请注意,文件大小并不重要,因为在恢复解决方案中使用了快照。通过使用快照,数据不会被拷贝回来,这非常耗时。相反,斑点的状态通过指回在恢复时刻当前的块斑点 id来恢复。

4.结论

企业数据湖中的一个普遍担忧是,由于应用程序错误或人为错误,数据会被破坏。在这种情况下,可能需要执行时间点恢复(PiTR)并恢复快照。启用了分层名称空间(HNS)的 Azure 存储尚不支持 PiTR。

在这篇博客和 git repo [azure-functions-datalake-recovery-pitr](https://github.com/rebremer/azure-functions-datalake-recovery-pitr)中,讨论了如何使用基于事件的快照创建、软删除和 Azure 持久功能来实现 PiTR 的可伸缩性,另请参见下面的架构。最后,讨论了如何通过使用更高的 SKU 和多个工作人员来纵向和横向扩展解决方案。

4.建筑——作者的图像

如何将你的神经网络的训练时间从几小时减少到几分钟

原文:https://towardsdatascience.com/how-to-reduce-the-training-time-of-your-neural-network-from-hours-to-minutes-fe7533a3eec5

关于使用 HPC 的人工智能的文章的第 2 部分:使用 Horovod 和 GPU 并行 CNN 以获得 75-150 倍的加速。

罗伯特·卡茨基在 Unsplash 上的照片

在本系列的第 1 部分中,我们研究了如何通过使用多处理模块的几行 Python 代码在 IO 操作中获得到 1500 倍的加速。在本文中,我们将研究并行化深度学习代码,并将训练时间从大约 13 小时减少到 13 分钟!

背景

作为一名数据科学家,你最终会面临以下问题(如果你还没有面对过的话)。

“我有一个要训练的神经网络,但输入数据不适合内存!” 或 “我的神经网络用这么大的数据量来训练,永远花不完!”

如果将你的一大部分数据排除在训练之外,或者等待几个小时(甚至几天)让你的神经网络完成训练,那肯定是很可惜的。必须有一个更好的方法,这就是所谓的数据并行。

问题是

在这篇文章中,我们将使用在 Kaggle 上可获得的百事公司实验室薯片控制数据集的修改版本。原始图像为 2000 x 2000 像素格式,有 3 个通道。我修改图像,将它们缩放到 500 x 500,并应用 5 次变换(一次垂直翻转、一次水平翻转和三次 90 度旋转)来创建比原始数据集中多 6 倍的图像。

这两种类型的芯片区分在这个职位。

然后,我编写了一个简单的卷积神经网络(CNN)代码,用于基于从原始数据集创建的输入数据进行分类。所有的材料都可以在这里找到。

这篇文章中使用的 CNN 是使用 visualkeras 可视化的。请注意,为了美观,第一层没有按比例绘制,但它给出了我为这个问题创建的微型 CNN 的概念。

资源和存储库

在本文中,我们将使用:

- 张量流 2 和 Keras

- 霍罗沃德

- Python 3.8+版本

- 至少有 1 个 GPU 的计算机

- 所有的代码和数据都可以在这个库中找到。

数据并行性

在数据并行中,我们部署相同的模型,在不同的处理单元(比如 GPU)上进行训练,但是使用输入数据的唯一子集。在每个时期之后,模型参数被收集、聚集并传送回处理单元,以继续训练它们各自的模型。通过这种方式,每个处理单元使用其自己唯一的数据子集(即数据的一部分)来训练相同的模型,但是模型参数会随着对整个输入数据集的了解而更新。

我如何将这种方法用于神经网络?

如果你使用 TensorFlow、PyTorch 或任何流行的公共深度学习框架,你可以使用 Horovod 进行分布式训练。Horovod 是由优步开发的,目的是将 HPC 的思想引入深度学习。安装相当简单,我就不赘述了,因为他们的 GitHub 页面很好地解释了这一点。在这篇文章的剩余部分,我们将讨论如何使用 Horovod 数据并行化他们的 TensorFlow 代码。

把 Horovod 想象成你现有代码的一个插件。在Horovod-ing你的代码中涉及的步骤遵循数据并行的思想,所以在做任何事情之前,你必须完全理解你的代码将如何被 horo VOD 执行。然后,您必须决定分发数据的方式。一旦完成,就可以开始在代码中实现 Horovod 了。

对我来说,用下面的步骤来处理这个问题更容易。

- 了解你的代码将如何用 Horovod 执行,即 horovodrun

- 确保您有一个好的数据分发策略

- 在代码中初始化 Horovod

- 确保您的优化器是分布式的

- 从协调器广播您的变量并修复您的回调

我们现在将详细讨论每一点。

1.Horovod 如何运作

Horovodrun 将一些基本的消息传递接口(MPI)命令和概念封装到一个更高级别的 API 中。因此,如果熟悉 MPI 的话,您可以发现两者之间有很多相似之处。在一个有 n 个 GPU 的系统上,人们会执行一个 CNN 代码,这里已经实现了 Horovod,如下所示

horovodrun -np **n** python cnn_parallel.py

用 Horovod 修改过的代码需要用 horovodrun 或 mpirun 来执行。对于数据并行框架,使用 n 个 GPU 可以创建 n 个任务。每个任务都使用 python 运行修改过的 CNN 代码,但是只针对数据的一个唯一子集。在下图中,我也做了同样的解释。我们正在一台有 2 个 GPU 的机器上工作。输入数据集 D 被分成两个子集 a 和 b,使得它们之间没有共同的元素。

理解 Horovod 如何并行执行代码。

这里要记住的重要一点是,您的整个 python 代码将运行 n 次,其中 n 是 GPU 的数量。因此,每个打印命令,每个 IO 操作,每个绘图部分等。将被执行 n 次。起初这可能是一个令人困惑的概念,但好的一面是每个屏幕上的消息(例如 print(…))都有自己的 GPU 标识符。

Horovod 附带了一些有用的调用(类似于 MPI 标准定义的调用),帮助定义我们将在其上运行代码的系统的架构。“hvd.size()”命令显示实际可用的 GPU 数量,“hvd.local_rank()”告诉您 GPU 的本地等级,“hvd.rank()”告诉您 GPU 的全局等级。等级可以被认为是 GPU id。下图更好地解释了这个想法。

了解单节点与多节点设置中 GPU 的大小和等级。

2.数据分发策略

那么,为什么必须分发数据呢?为了充分利用数据并行性,每个 GPU 必须看到唯一的数据子集。然而,如果您传递相同的数据集进行训练,您将在 n 个 GPU 上使用相同的样本对模型进行 n 次训练,或者换句话说,您将使用相同的数据以完全相同的方式运行代码 n 次。这不是我们想要通过数据并行实现的。

为了正确地分配数据,可以采用许多策略。Pytorch、Tensorflow 等都有内置的数据分发方法。,但实际的策略将取决于数据的结构和数据量。

让我们用一个简单的例子来创建一些数据分布策略。假设我们的数据由从 1 到 100 的所有整数组成,按升序排列,没有重复。我们希望将这些数据分布在 2 个 GPU 上。

选项 1:张量流数据生成器

我们将在训练开始时采用在 GPU 上随机分配批次的想法。我们将欺骗 TensorFlow 中的 fitting 调用,使用“steps_per_epoch”关键字将 1/n 个批次分配给每个 GPU。这种方法适用于数据生成器,在我们的例子中是图像数据生成器。我们保持与我们在没有任何 GPU 的情况下训练时相同的批量大小。

用张量流数据发生器进行数据分配。

img_gen = tf.keras.preprocessing.image.ImageDataGenerator(validation_split=split)train_dataset = img_gen.flow_from_directory(directory= train_data_path,target_size=(img_height,img_width), color_mode=**'rgb'**,batch_size=**batch_size**,class_mode=**'sparse'**,seed=123, shuffle=True, subset=**'training'**)val_dataset=img_gen.flow_from_directory(directory=... subset=**'validation'**)**total_train_batches** = train_dataset.samples//batch_size**total_val_batches** = val_dataset.samples//batch_size

然后,当我们执行拟合时,我们指示 TensorFlow 仅使用总批次的 1/n 进行训练和验证。这是因为训练将在每个 GPU 上进行,并且通过将“steps_per_epoch”指定为 total_batches/n,我们指示 TensorFlow 在两个 GPU 上拆分批次,以便每个 GPU 从我们的数据生成器获得批次的不相交子集。

history = model.fit(train_dataset,epochs=epochs,batch_size=batch_size,**steps_per_epoch=total_train_batches//hvd.size(),**validation_data=val_dataset,**validation_steps=total_val_batches//hvd.size(),***...*

)

方案二:张量流数据。数据集对象

我们将使用“分片”的概念,这相当于获取数据集中的第 q 个元素。下面的伪代码应该能更好的解释。

D = [1,2,...,99,100]# split into 2 shards

shard_1 = [1,3,5,...]

shard_2 = [2,4,6,...]# split into 3 shards

shard_1 = [1,4,7,...]

shard_2 = [2,5,8,...]

shard_3 = [3,6,9,...]

下面我描述了两种不同的方法,每批 4 个。请注意,这些不是分发数据可以采用的唯一策略,您可以自由设计自己的策略。

- 方法 A:将数据集分片 2 次→批量化

- 方法 B:混洗数据集→分片 2 次数据集→批量处理

从机器学习的角度来看,你能解释为什么只有一种方法是正确的吗?

D = [1,2,...,99,100]**# method A**shard_1 = [1,3,5...]

shard_2 = [2,4,6...]shard_1_batch = [[1,3,5,7],[9,11,13,15]...] # split 1

shard_2_batch = [[2,4,6,8],[10,12,14,16]...] # split 2**# method B**D_shuffle = [63,74,22,26,36,14,34,94,60,42,56,17,65,1,12,51...]shuffle_shard_1 = [63,22,36,34,60,56,65,12]

shuffle_shard_2 = [74,26,14,94,42,17,1,51]shuffle_shard_1_batch = [[63,22,36,34],[60,56,65,12]...] # split 1

shuffle_shard_2_batch = [[74,26,14,94],[42,17,1,51]...] # split 2

使用方法 A,所有奇数都在分割 1 中结束,偶数在分割 2 中结束。很明显,方法 B 是最好的,因为产生的分割公平地表示(和分布)了偶数和奇数。

现在想想 CNN 的输入。理想情况下,输入文件夹将包含数千(如果不是数百万)您需要训练的图像,通常分组到不同的类别(子文件夹)。当您从图像文件夹中创建 TensorFlow 数据集时,它会从目录结构中推断出类。下面的片段应该能更好地阐明这一点。

**input_folder

|-train

| |-class_1**

| | |-image_1.jpg

| | |-...

| | |-image_100.jpg

**| |-class_2**

| | |-image_1.jpg

| | |-...

| | |-image_50.jpg

**| |-class_3**

| | |-image_1.jpg

| | |-...

| | |-image_500.jpg

因此,一旦这样的文件夹结构被传递给 TensorFlow,它会自动将文件名映射到它们各自的类,准备好进行处理并传递给 CNN 进行训练。注意,默认情况下,image _ dataset _ from _ directory会打乱文件名,或者换句话说,如果您使用它摄取图像,您的数据集已经被打乱了。

使用分片的数据分发。

import tensorflow.keras.preprocessing as tkplocal_bs = .. # will be scaled with the hvd.size() # we will discuss this laterX_train = tkp.image_dataset_from_directory(..., batch_size = 1) train_dataset = X_train.**unbatch()**.**shard(hvd.size(), hvd.rank()).batch(local_bs).cache()**

hvd.shard() 调用接受 GPU 的数量(创建多少个碎片)和 GPU 的 id 来创建数据的唯一碎片。使用 hvd.size()和 hvd.rank()作为该调用的输入,我们可以轻松地管理将由每个 GPU 处理的数据分割。至此, train_dataset 尚未创建,因此不存在于内存中。它将在最终使用下面的命令训练模型时创建。

model.fit(train_dataset,...)

注意,这里我们使用了 *local_bs,*来代替原来的批量大小。我将很快解释原因。

数据分发后训练模型

一旦我们正确地决定并实现了数据分发策略,我们就准备好训练 CNN 了。此时,使用 2 个 GPU,数据训练策略将被执行,如下所示。

训练 CNN 时执行的数据分发策略。

批量大小和学习率(数据分布策略中的选项 2)

如果你使用过神经网络,你必须熟悉学习率和批量的概念。在数据分布式框架中,人们可能需要正确地调整这些,以补偿我们的训练策略的变化。由于每个 GPU 现在都在用唯一的数据子集训练模型,NN now 在每个时期有效处理的样本数量与批量大小不同。请注意,根据您决定如何分发数据以及如何编写代码,您可能不需要执行这种缩放。根据我的经验,如果相应地调整批量大小和/或学习率,上面的数据分布选项 2 通常会更好。基本上,如果您在实现数据并行后发现奇怪的损失和准确性曲线,那么这可能是要记住的事情。

让我们回到选项 2 的数据分发。我们有 2 个 GPU,数据集由 100 个整数组成,批量大小为 4。每个 GPU 获得 50 个唯一的整数,分组为大小为 4 的批次。每个 GPU 通过处理其自己的 13 个批次(最后一个批次将只有 2 个元素)来执行训练,并且在每个时期之后,模型参数被传递到 Horovod 用于聚合。Horovod 从批量大小为 4 的 GPU 0 和批量大小为 4 的 GPU 1 聚合模型参数,因此有效地批量大小为 8!换句话说,当 Horovod 在每个时期结束时更新模型参数时,模型在技术上“看到”了一个批次,其中每个批次具有 8 个独特的样本。下图应该能更好地解释这一点。

基于两个 GPU 的 CNN 数据分布式训练。在每个时期结束时,Horovod(橙色)聚集来自每个 GPU(蓝绿色和紫红色)的模型参数,并更新 CNN 模型,现在为下一个时期的训练做好准备。

在我们不改变批量大小的情况下,即保持其固定为与代码的非数据分布版本相同的值,我们必须随着 GPU 的总数线性调整学习速率。这是因为在我们的有效批次*中有更多的样本,可以增加算法在寻找损失函数最小值的过程中允许采取的步长。换句话说,我们有更少的噪声(更多的样本),因此我们可以在参数空间中进行更大的跳跃,以便找到最小值。

然而,如果我们希望保持固定的学习速率,即与代码的非数据分布版本相同,我们必须与 GPU 的数量成反比地调整批量大小。让我们以整数为例。对于 2 个 GPU,如果我以 2 的批处理大小对我的每个数据分片进行批处理,那么 Horovod 在每个 epoch 结束时看到的有效批处理大小是 4。因此,我可以保持与数据分发前相同的学习速度。

总结一下:

############################################ THEORY

# original batch size: batch_size

# local batch size: local_bs (batch size on each gpu)#original learning rate: lr

#scaled learning rate: scaled_Llr## option 1:

# bs= local_bs : therefore, the effective batch size is larger

# therefore scaled_lr = lr*n_gpus## option 2:

# scaled_lr = lr

# therefore local_bs = batch_size/n_gpus

# now the effective batch size will be the same as before

######################################################################################## IMPLEMENTATION

#**pick one** below:

**# Option 1:**

# local_bs = batch_size

# scaled_lr = base_lr * hvd.size()

# **OR

# Option 2:** local_bs = int(batch_size/hvd.size())

scaled_lr = base_lr

- 有时,学习率的平方根缩放或 2/3 幂缩放比严格的线性缩放效果更好

3.在代码中初始化 Horovod

第一步是告诉你的代码你将使用 Horovod。

**import horovod.tensorflow as hvd****hvd.init()** # this initiliases horovodprint('Total GPUs available:', hvd.size())

print('Hi I am a GPU and my rank is:', hvd.rank())

下一步是使用 GPU 的本地等级作为标识符,将每个可用的 GPU 固定到一个“进程”。

*# Pin GPU to be used to process local rank (one GPU per process)*

gpus = tf.config.experimental.list_physical_devices('GPU')

for gpu in gpus:tf.config.experimental.set_memory_growth(gpu, True)

if gpus:tf.config.experimental.set_visible_devices(gpus[hvd.local_rank()], 'GPU')

4.分发优化器

这是优化器进行聚合的地方。Horovod 使这变得非常容易,因为我们只需要在代码中添加一行来分发优化器。

opt = keras.optimizers.Adam(learning_rate=learning_rate)# Horovod: add Horovod Distributed Optimizer.

**opt = hvd.DistributedOptimizer(opt)**

5.修复回电

下一步是确保我们不会通过允许所有 GPU 更新模型参数来破坏我们的训练。因此,我们将我们的一个 GPU 声明为“协调器”。这个 GPU 将负责收集模型参数,聚合它们,并在每个训练时期后将它们广播回其他 GPU。请记住,它也将使用自己的数据子集来训练 CNN。通常我们声明排名为 0 的 GPU 为我们的协调器。

callbacks = [# Horovod: broadcast initial variable states from rank 0 to# all other processes. This is necessary to ensure consistent# initialization of all workers when training is started with# random weights or restored from a checkpoint.**hvd.callbacks.BroadcastGlobalVariablesCallback(0),**# Horovod: average metrics among workers at the end of every# epoch.**hvd.callbacks.MetricAverageCallback(),**]# Horovod: save checkpoints only on worker 0 to prevent other

# workers from corrupting them.

**if hvd.rank() == 0:callbacks.append(keras.callbacks.ModelCheckpoint('...h5'))**

运行代码

我们现在准备运行代码。如果您使用的计算机只有 1 个 GPU,您可以从终端执行该命令,如下所示

horovodrun -np 1 python python_code/horovod_dist_gen.py

相反,如果我们要在一台超级计算机上运行它,我们需要编写一个脚本来提交我们的“作业”,其中作业是一段要用给定的资源组合运行的代码。下面是一个脚本的例子,我在一台有 4 个 GPU 的机器上运行代码。

使用带有 Horovod 的 GPU 运行 CNN 代码的 slurm 脚本。

结果如何呢?

无 GPU 时间:14 小时

使用 1 个 GPU 的时间:12 分钟

对于使用碎片的数据分发方法,我们使用 1 个 GPU 获得了 75 倍的速度提升,使用 2 个或更多 GPU 获得了150 倍的速度提升。

在我们的 CNN 代码中实现 Horovod 并使用 1、2 和 4 个 GPU 运行后获得的加速。

与生成器方法相比,以碎片形式分布的数据性能更好。从 1 个 GPU 到 2 个 GPU 的加速几乎是线性的,即 75 倍到 150 倍,但之后就不再加速了。这是为什么呢?这是因为当我们并行处理一个代码时,我们的想法是最大限度地利用可用资源。有了 1 个 GPU,即使代码运行速度比没有 GPU 时快 75 倍,也仍然有从更多计算能力中受益的空间。当我们添加第二个 GPU 时,运行时间减半,从而导致理想的线性加速。此时,我们处于这样一个阶段,即提供给代码的资源对于计算量来说是最优的。增加更多的资源对我们没有好处。因此,我们看不到 4 个 GPU 有更多的速度提升。我们可以使用命令 *nvidia-smi 来监控资源使用情况(在我们的例子中是 GPU 使用情况)。*我不会深入探讨这个话题,但如果你有兴趣,请随时联系我。

结束语

- 请随意设计您自己的数据分发策略。这通常取决于你的数据是如何组织的,以及数据的大小。

- 使用 GPU 时,初始设置总会有开销,即根据您使用的系统,可能需要一些时间来设置 GPU-CPU 通信、环境变量等。这是由引擎盖下的系统完成的,所以如果在开始时代码似乎停顿了几秒钟,它很可能只是在设置 GPU。

- 为了简单起见,我只对训练部分计时。原则上,人们可能需要对整个代码的运行时进行基准测试。这取决于你想优化什么。

- 为了正确测试性能,需要多次运行相同的代码,以获得更好的运行时统计数据。

- 还必须检查模型的收敛性,即使用 GPU 的并行化训练应该收敛到与在没有 GPU 的运行中看到的相同的损失和精度值。此外,无论使用多少个 GPU,精度和损耗曲线都应该收敛到相同的值。

如何消除机器学习训练数据中的偏差

原文:https://towardsdatascience.com/how-to-remove-bias-in-machine-learning-training-data-d54967729f88

理解和减少人工智能/人工智能项目训练数据中的偏差

图片作者:作者

在人工智能/人工智能的世界里发生了很大的变化,但是“垃圾”的概念;“清除垃圾”仍然是坚忍的。任何算法的好坏都取决于它的训练数据。而且,没有任何训练数据是没有偏见的,即使是通过自动化生成的数据也是如此。

在过去,许多机器学习算法对某些宗教、种族、性别、种族和经济地位等不公平。IBM 的沃森超级计算机使用医学研究论文数据集向医生提供建议,被发现只支持声誉良好的研究。亚马逊的招聘算法被发现对男性比对女性更有利。COMPAS 是一种风险评估算法,被美国许多州的法官用来帮助判决,因在暴力犯罪中给黑人分配更高的再次犯罪风险系数而受到争议。2016 年,微软对一个 Twitter 聊天机器人(从其他推文中学习)进行了一天的实验,结果糟糕地结束了,该机器人在 16 个小时内发布了 95000 条推文,其中大多数都充满了厌女症、种族主义和反犹太主义思想。

但是,事情是这样的——算法不是不道德的、种族主义的或道德上有缺陷的。然而,他们接受训练的数据是另一回事。

数据偏差很复杂

偏差会破坏多个结点的数据。在收集、数据聚合、模型选择甚至最终用户解释的过程中,它可能会渗入到无害的数据集中。事实上,几乎可以假设没有任何数据不存在这样或那样的偏差。可能是人类训练者的外部偏见造成的。或者,它可能是数据集中任何组的过度简化或不令人满意的表示的结果。

根本原因并不总是很明显。但是,影响是!

数据偏差对机器学习的影响

有偏差的数据集是不平衡的。它未能代表机器学习模型的原始动机。它的结果是不准确的,它的决策是有偏见的,并且它的精度水平可以在不同的环境下变化,从而违背了模型的目的。

COMPAS(替代性制裁的矫正罪犯管理概况)是一个非常受欢迎的例子,说明了在有偏见的数据上训练的自给自足算法的后果。它使用一份问卷来评估罪犯的各种参数,并预测他们再次犯罪的可能性。这一预测被美国许多州和司法管辖区的法官用来量刑。

在几个有问题的决定、关于其完整性的各种问题和几起诉讼之后,ProPublica 检查了该算法的风险评估因素,并观察到两大荒谬之处。

预测精度低于 20%

黑人罪犯被贴错标签的 2 倍

COMPAS 仅仅是一个例子,它展示了由于有偏见的 ML 模型,人类可能不得不遭受的非常真实的后果。任何 AI/Ml 模型的实施范围的影响直接受到算法获得的训练的性质的影响,因此,对创建所述数据集的 数据注释服务 产生影响。

数据偏差的类型

图片作者:作者

样本偏差:

当在研究过程中意外地或有意地排除了一组数据时,样本(或选择)偏差就被引入了系统。这样的样本将不会真实地反映预期的可观察环境,并导致不准确的结果。

**例如,**考虑一个数据集,该数据集研究一个地区 15 年的人口数据,以帮助预测新租户的租期。如果我们错误地将 15 年的期限解释为绝对期限,并将在当地居住时间少于 15 年的租户排除在我们的研究之外,那么可能会引入偏见。删除这样的数据会使模型无效,因为它不会在每个可能的情况下都被训练。

算法偏差:

算法偏差是一种系统误差,它会导致糟糕的计算。它可能是预先存在的问题,也可能是由于程序限制或设计约束而出现的。如果一个特定的算法被用在一个它没有被训练过的环境中,算法偏差也会显现出来。

**例如,**考虑任何自动剽窃检查器,它将超过三个单词长的字符串与一组内容进行比较,并返回相似率。如果目标内容是旋转的,单词用同义词改变,算法的准确率就会下降。

偏见:

偏见的范围很广。它从基于地区的术语差异发展到围绕种族、宗教、性别、性等的更深层次的歧视。数据集中的偏见是由于数据训练者的观点而产生的。

例如,英国的一个数据标注团队仔细查看了女性钱包的图片,并将其标注为钱包。对于美国的数据接收者来说,这种模型将产生无效的结果,因为在美国,“钱包”指的是女人的手提包,而不是钱包。

测量偏差:

数据测量或收集中的问题会导致测量偏差。这种变形可能是分类错误、用于数据捕获的不同工具或基本注释错误的结果。

例如,考虑一个 图像注释服务 提供商,该提供商致力于为自动驾驶项目标记车辆的项目。如果数据集只有道路上车辆的图像,而没有行人或流浪动物的图像,那么训练员将没有其他可标记的内容。最终标记的数据和它给予 ML 模型的训练将非常无效。

排除偏差:

在清理过程中,会对数据集的几个要素进行加权,不重要的要素通常会被移除。然而,如果我们对任何重要的特征赋予较低的重要性,我们可能最终会创建一个具有一些未被充分表示的部分的数据集,从而导致一个有偏见的模型。

例如,考虑一组来自女性的绝经前症状——90%为白人,10%为西班牙裔。很可能这 10%的人被忽视了,因为他们的症状没有被认为是主流。由此产生的算法不太可能诊断出需要帮助的西班牙妇女。

回忆偏差:

在收集过程中,回忆偏差也包含在数据中。如果数据提供者提供的是一个估计值,而不是一个精确值,这将动摇数据集的整体准确性。因此,我们可以认为这是一种测量偏差。

但是,数据注释中的直接回忆偏差的一个例子可以在以下情况下观察到:训练者的标签数据基于近似,并且不一致性重复足够多次,使得数据对于某个特征不可靠。

观察者偏差:

在标注过程中,训练者可能会将其对特定数据要素的看法投射到数据集中,从而导致观察者产生偏差。

两个人给同一组图像加标签会得出不同的结果。例如,尽管指示将图像标记为船或非船,但训练员可能将一艘船标记为游艇,而将另一艘船标记为轮船,从而破坏了结果数据集中的一致性。

对于https://www.suntecindia.com/text-annotation-services.html文本注释服务,观察者偏差也是一个非常常见的现象。我们向供应商提交的文档可能会落入不同地区不同人的任务列表中。他们可能对笔迹有不同的理解,从而在整个数据集中产生明显的不一致。

代表性偏差:

如果我们拿两个相似的情境,仅仅因为相似性就根据另一个来预测其中一个的结果,这将导致表征偏差。表征偏差在流行的短语中被拟人化了——“相关性并不意味着因果关系。”

例如,如果一个算法评估学生的成绩,并预测那些成绩相似的人将进入某个特定的大学,因为他们中的少数人进入了,那么这个预测的准确率将会很低。

同时,如果我们只在数据集上训练算法,而该数据集在算法的预期环境中对所有组没有相等的表示,这也将导致偏差。例如,如果我们只用白人男性的数据集来训练员工面部的算法,它将很难检测出肤色较深或头发较短的女性等。

识别和处理机器学习训练数据集中的偏差

这些例子证明了偏差在本质上是多种多样的,并且可以在其生命周期中的任何点进入样本集。许多偏见并不明显。许多与其他过程混合在一起,以至于识别它们似乎是一个难以管理的挑战。

有几种提议的技术来建立公平感知的机器学习模型。已经开发和研究了许多方法来减少机器学习的训练数据中的偏差,每种方法都遵循不同的上下文。他们中的大多数归结为一件事——在每一步都保持谨慎和好奇是至关重要的。

1.质疑先入为主

机器学习模型从历史决策及其意图中学习,其中意图是已知的。因此,如果过去的决策者在他们记录的决策中表现出任何偏见,ML 模型将面临反映这些偏见的风险。

如果在数据标注期间,训练员将西伯利亚哈士奇和瑞典猎兔犬的图片标记为狼,模型将学习做同样的事情。如果一家公司最近的 20 次招聘是为了 19 名男性和 1 名女性,那么从这一决策数据中学习的 ML 模型可能会丢弃比男性更多的女性简历。

因此,在训练数据准备的每个阶段,询问数据来自哪里,谁的观点影响了早期的决策,以及需要对数据进行哪些相应的更改来清理数据以用于训练目的是很重要的。

2.消除偏见

这个想法很有挑战性;它的实现更是如此。

消除偏见需要对可能污染数据的先入之见有一个近乎彻底的了解。但是,根据机器学习模型的目标,根除潜在的导致偏见的感知可能从还好到非常棘手。

您可以记录组织过程中的问题,并修复它们。但是,在多个动态参数上训练模型时这样做将带来许多新问题。例如,如果你的 ML 模型使用 100 个人的社交媒体帖子来确定他们的就业能力得分,这可能对来自母语不是英语的国家或来自不发达国家的潜在客户不公平。

因此,尽管我们尽了最大努力来识别潜在的偏见并将其根除,但最好是测试结论并验证其有效性。

3.不要放松监督

适用于一组数据的算法不太可能适用于同一数据的扩展版本。如果我们继续用 challenger 模型测试该系统,并验证其预测准确性、透明度和改进率,就有可能。

尽管如此,假设任何机器学习模型都能自给自足都是错误的。随着数据、其预期环境和目标对象的变化,其准确率也会变化。

目前,基于现实世界的机器学习模型中的偏差仍将是一个人工智能难题

尽管有几种合理的公平方法,但机器学习模型在某个领域仍不尽如人意。期望一个模型同时满足多个动态约束并保持其预测精度是不可能的。我们需要根据具体情况做出选择。

然而,目前,创建相当公平的机器学习训练数据主要取决于数据标注和处理。希望在不久的将来,我们会有更具体的方法来创建公平的数据集。

也读作:

为什么外包数据标注更好?

为什么外包视频注释服务对企业有利可图?

Python 熊猫:重命名 DataFrame 列的 4 种惊人方法

原文:https://towardsdatascience.com/how-to-rename-columns-in-pandas-with-examples-24c983fcc3b8

计算机编程语言

了解并掌握这些方法来处理熊猫数据框架中混乱的列名

贾里·海托宁在 Unsplash 拍摄的照片

熊猫是一种快速、有力、灵活的动物!🔋

导入到 pandas DataFrame 中的数据有时会有不正确或混乱的列名,您需要重命名全部或部分列名。

用有意义的列名替换混乱的列名是数据清理的重要步骤。这无疑使整个代码更具可读性,并在接下来的数据处理步骤中节省了大量时间。⏳

今天,我将演示 4 种最好的方法来轻松地更改熊猫数据帧的列名。

📍注意:我使用的是自己创建的 Dummy_Sales_Data ,你可以在我的Githubrepo 上免费获得&用于你的其他练习项目!

让我们首先导入数据集,

import pandas as pd

df = pd.read_csv("Dummy_Sales_Data_v1.csv")

df.head()

虚拟销售数据|作者图片

这是一个简单的 10000 x 12 的数据集,是我在文章 Faker 中创建的:一个惊人且非常有用的 Python 库 **。**📚

你可以在本文末尾下载一个完整的笔记本,里面有所有这些例子!

好吧,我们开始吧..

在深入研究其他方法之前,让我们从最简单直接的方法开始。

熊猫。DataFrame.rename() —使用字典

这是一个数据帧功能,主要用于改变轴标签。这里,单词— 轴— 指的是行和列,这取决于我们在该函数中为参数axis设置的值。

因为我们更有兴趣了解如何更改列名,所以让我们把重点放在它上面。因此,.rename()函数中的重要参数是如下所示的columns。

熊猫。DataFrame.rename() |图片作者

要替换部分或全部列名,您只需传递一个字典,其中键将是旧列名,而值将是新列名,如下所述。🔽

df.rename(columns={"Status": "Order_Status","Quantity": "Order_Quantity"}).head()

使用 df.rename() | Image by Author 重命名 pandas dataframe 列

如你所见,我在df.rename()中的参数列中传递了字典,其中 键 是旧的列名状态和数量。而 值 是订单 _ 状态和订单 _ 数量这是新的列名。

📍注:

df.rename()包含一个inplace参数,默认为假。为了保留列名中的更改,您需要执行inplace = True。

因为我不想保留更改后的列名,所以我使用了.head()方法来查看更改后的列名。

📍注意:在任何函数中使用

inplace = True之前,最好使用.head()来看看变化看起来如何。

接下来的方法是.rename()函数的一个微小变化。

熊猫。DataFrame.rename() —使用函数

就像上面的第一种方法一样,我们仍然会使用.rename()函数中的参数columns。但是除了传递旧名称-新名称键-值对,我们还可以传递一个函数给列参数。

例如,使用这个技巧将所有列名转换成大写字母非常简单,如下所示

df.rename(columns=**str.upper**).head()

使用函数|作者图像重命名列名

我简单地使用了一个字符串函数**str.upper**让所有的列名都是大写的,正如你在上面的图片中看到的。

这里可以使用的字符串函数的完整列表在Python 中的五个必知字符串方法 中有所提及📚

通过这种方式,所有的列名将被一次性修改。然而,这可以通过用户定义的函数来实现。

*是的!!*您可以向参数columns传递任何用户定义的函数,以根据函数更改列名。

例如,您可以编写一个简单的函数来拆分下划线( **_** )上的列名,并只选择其中的第一部分。然后将这个函数传递给如下所示的列。🔽

def **function_1**(x):x = x.split('_')[0]return xdf.rename(columns=**function_1**).head()

根据用户定义的函数更改列名|按作者排序的图像

在上面的输出中可以注意到更改的列名。根据应用的功能,包含**_**的列名在**_**上被拆分,只有第一部分被指定为新的列名,例如 Product_Category 变成 Product 。

如果它是一个简单的函数,就像上面的一样,你也可以使用 lambda 函数。♻️

接下来让我们看看重命名列的另一种方法..

熊猫。数据框架.列

实际上,这是返回数据帧的所有列名列表的方法,例如

df.columns

使用 df.columns | Image by Author 列出列名

然而,反过来,我们可以将新列名的列表传递给df.columns,然后新列名将被分配给数据帧。

这是它的工作原理..🔽

df.columns = ['OrderID', 'Order_Quantity','UnitPrice(USD)', 'Order_Status','OrderDate', 'Product_Category','Sales_Manager', 'Shipping_Cost(USD)','Delivery_Time(Days)', 'Shipping_Address','Product_Code', 'OrderCode']

df.head()

使用 df.columns | Image by Author 一次更改所有列名

正如你所看到的,我将新列名的列表分配给了df.columns,所有列的名称都相应地改变了。

📍注意:您需要传递所有列的名称。该名称列表的长度必须正好等于数据帧中的列总数。

并且没有任何其他选项,比如inplace,列名被直接永久地改变,这种方法有点冒险。⚠️

因此,我建议只有当您 100%确定想要更改列名时才使用它。

📍注意:列名列表的顺序应该与数据帧中列的顺序相同,否则列名可能会分配错误。

记住以上几点,这是一次性改变所有列的最好方法。

让我们看看最后一个方法..

熊猫。DataFrame.set_axis

该方法最初用于为数据框的轴设置标签,即该方法可用于标记列和行。

您只需将列名列表传递给**.set_axis()**函数,并指定**axis = 1**来重命名列,如下所示🔽

df.set_axis(['A', 'B', 'C', 'D', 'E', 'F','G', 'H', 'I', 'J', 'K', 'L'], axis=1).head()

使用 set_axis() | Image by Author 更改列名

这是您可以更改所有或部分列的列名的方式。这里也必须考虑我在前一个方法中提到的所有要点。

然而,.set_axis()是先前方法df.columns的更安全版本,因为它包含了参数**inplace**。因此,即使在应用更改之前,您也可以预览未来的更改。

要保留更改后的列名,只需使inplace = True。

这就是改变列名的全部内容!!

我希望你觉得这篇文章有趣,有用,令人耳目一新。让列名可读性更强、风格更统一总是好的。因此,重命名列是项目开始时需要完成的基本步骤之一。

💡通过 成为中级会员 可以探索中级物品。相信我,你可以访问无限的故事媒介和每日有趣的媒介文摘。我会得到你的费用的一小部分,没有额外的费用给你。

💡不要忘记 注册我的电子邮件列表 来接收我的文章的第一份副本。

📚下面是一个完整的 笔记本 用所有这些方法来重命名列。

感谢您的阅读!

如何在 2 个简单的步骤中在 Tableau 中渲染混合几何类型

原文:https://towardsdatascience.com/how-to-render-mixed-geometry-types-in-tableau-in-2-simple-steps-27b56a2153c4

没有 LOD 计算。用 JavaScript 将空间数据集转换成表格格式。包括完整的代码片段。

近年来, Tableau 凭借其在市场上的高采用率,一直是顶尖的数据分析工具之一。毫无疑问,其商业成功的一个显著原因是其为用户无缝集成多种数据格式的多功能性。

作者截图|浏览 Tableau 的数据源选择页面|注意“空间文件”在这里被突出显示(稍后将详细说明)

例如,Tableau 广泛的数据选择菜单包括一个名为**“空间文件”**的选项,其中所述文件类型通常作为地图可视化显示在仪表板中。一个典型的例子是作为包含地理信息的 JSON 对象存储在文本文件中的geo JSONfeature collection。

(注意:所有 GeoJSON 对象都遵循以下约定。)

{ "type": "FeatureCollection","features": [{ "type": "Feature","geometry": {...},"properties": {...}}]

}

尽管 Tableau 能够读取地图数据集,但一个明显的限制是它无法从单个空间数据源呈现多种几何对象类型—

PolygonMultiPolygonPointMultiPointLineStringMultiLineStringGeometryCollection。

相反,Tableau 用户通常会遇到以下错误消息:

Image by Author |导入同时具有线串和点几何类型的空间文件时,Tableau 显示错误

用例:新加坡国家铁路的地理空间可视化

**注:**触发上述错误的完全相同的 GeoJSON 文件将用于后续演示。

原始文件可在SG-rail-layer . geojson|以上 geo JSON 输出由从https://data.gov.sg/提取的两个特定原始数据源**【1】和【2】**合并而成(参见以下引用)

原始数据源:

**【1】**从总体规划-2019-铁路线层(上传于 2020 年)中检索,并于 2022 年 6 月 6 日访问,根据新加坡开放数据许可证的条款提供

**【2】**从总体规划-2019-铁路-车站-图层(上传于 2020 年)中检索,并于 2022 年 6 月 6 日访问,根据新加坡开放数据许可证的条款提供

实施细节

实质上,为了绕过上述问题,另一种方法是将地理空间信息作为单一记录(即表格格式)输入 Tableau,以取代其原始格式。

将行记录导入 Tableau 不仅可以消除任何类似或相关的错误,还可以按预期有效地读取和呈现。

(注意在本文中,表格数据格式的选择应为 基于行的 JSON )。其他表格格式,如 excel 或 CSV 格式也可以。)

数据转换过程总共有 2 个步骤 。

第一步。提取所有嵌套的几何体对象

如前所述,存在的各种类型的几何体对象有— Polygon MultiPolygon Point MultiPoint LineString MultiLineString GeometryCollection

因此,该步骤的主要目标是分解这些嵌套几何图形的粒度,使得 GeoJSON 对象中只存在Polygon Point LineString。完成这项工作的 JavaScript 代码片段如下(uncombineGeometriesInFeatureCollection(geojsonObj)):

**参考消息:**输出的 GeoJSON 原始数据文件可从SG-rail-layer-un combined . geo JSON中检索

第二步。将所有要素对象转换为对象数组

此后,transformFeatureCollectionToRowJSONObj(inputGeojsonObj)下面的 JavaScript 代码片段遍历每个 feature 对象并生成相应的行记录:

解释:

- 字段

F_ID被附加到每个特征,以便将其“父特征”标识为单个行记录 - 因此,当在 Tableau 中读取时,每个未合并的要素(例如,多面到面)被标记为字段

F_SUBID作为其单独的标识符 - 每个几何体对象都包含一个深度不同的坐标数组(取决于几何体类型)

- 因此,每个坐标对必须作为单行记录输出**,以便以表格格式正确解释(1 个坐标对= 1 行记录)**

- 对于每个特征对象,除了 6 个字段 —

F_IDF_SUBIDGeometry TypePT_ORDERXY之外,生成properties对象中的字段,并作为每个坐标对的 JSON 对象输出

var obj = {"F_ID":0, // Parent feature ID"F_SUBID":0, // Nested Geometry ID (before being unmerged)"Geometry Type":"", // Point,Polygon or LineString"PT_ORDER":0, // Position in array of Geometry Coordinates"X": 0, // longitude"Y": 0 // latitude

};

var rowObj = {...JSON.parse(JSON.stringify( <properties obj> )), // deep copy...obj

};

代码成功运行后,产生的输出将是一个rowObj数组,该数组随后可以用存储在一个单独的文件中。json 文件扩展名。

概念验证—展示 Tableau 输出

为了测试空间数据是否被正确转换,在 Tableau 数据选择菜单上,将文件作为**“JSON 文件”**导入:

作者截图|“JSON 文件”选项在菜单选项列表中被选中,而不是“空间文件”

如下图所示放置每个尺寸后,所有几何对象(即线串和点)将继续渲染新加坡的火车站和铁路网:

作者截图| Tableau 中 JSON 输出的显示。请注意,在“标记”面板中,选择了“线条”而不是“地图”

**参考消息:**以上 Tableau 文件可以从 Tableau Public 的链接下载🔗表格中混合几何类型的演示(最好在桌面/PC 监视器设备上观看)

请随意调整它或使用您自己的用例的所有代码片段!🙃

现在你知道了!非常感谢你坚持到这篇文章的结尾!❤希望你觉得这篇文章有用,如果你想了解更多地理信息系统(GIS)、数据分析&网络应用相关的内容,请随时关注我的媒体。会非常感激—😀

— 🌮请给我买个玉米卷 ξ(🎀˶❛◡❛)

https://geek-cc.medium.com/membership

要了解更多 Tableau 技巧和变通方法,请随意查看下面的文章列表:

</5-lesser-known-tableau-tips-tricks-hacks-with-use-case-demo-463f98fbdc7e>

如何用字典列表替换数据框

原文:https://towardsdatascience.com/how-to-replace-dataframes-with-lists-of-dictionaries-41bd5d8d716a

由 Unsplash 上的 Element5 数码拍摄

Pandas DataFrames 是一种非常方便的读取、编辑和可视化小表格数据的方式。但是它们也有一些主要的缺点:

- 它们不能很好地处理 Python 原生数据类型

- 它们对嵌套数据不方便

- 有些操作可能会非常慢

- 它们占据了很多空间

当从 API 获取数据时,API 可能会返回一个 JSON 字符串。虽然有一种方法可以将 JSON 字符串转换成 DataFrame,但是一个好的旧字典列表会更好。

在本文中,我将比较数据帧和字典列表,并编写一个自定义类来重新创建字典列表中数据帧的主要功能。

记忆

假设你有一个卖水果的商店,想存储你的订单。对于这个例子,我们将生成一个 1000 个水果订单的随机列表。

现在,让我们比较一下这个列表和包含这个数据的熊猫数据帧之间的大小差异。我们可以使用 sys 库来这样做。

这给了我们以下结果:

List: 9032 bytes, DataFrame size : 111584 bytes

所以就内存而言,链表比数据帧表现得好得多。

打印对象

打印数据帧的头部会给我们带来很好的可读性(如果你在笔记本上阅读的话会更好):

id basket

0 0 [{'fruit': 'raspberry', 'price': 68, 'weight':...

1 1 [{'fruit': 'peach', 'price': 5, 'weight': 107,...

2 2 [{'fruit': 'banana', 'price': 99, 'weight': 20...

3 3 [{'fruit': 'peach', 'price': 67, 'weight': 158...

4 4 [{'fruit': 'pear', 'price': 1, 'weight': 90, '...

然而,有了字典列表,结果就不那么美好了。

[{'id': 0, 'basket': [{'fruit': 'apple', 'price': 89, 'weight': 68, 'color': 'blue'}, {'fruit': 'pear', 'price': 94, 'weight': 89, 'color': 'yellow'}]}, {'id': 1, 'basket': [{'fruit': 'strawberry', 'price': 26, 'weight': 86, 'color': 'red'}, {'fruit': 'banana', 'price': 76, 'weight': 244, 'color': 'pink'}, {'fruit': 'pear', 'price': 90, 'weight': 123, 'color': 'pink'}, {'fruit': 'peach', 'price': 83, 'weight': 65, 'color': 'pink'}, {'fruit': 'banana', 'price': 83, 'weight': 229, 'color': 'yellow'}]}, {'id': 2, 'basket': [{'fruit': 'raspberry', 'price': 8, 'weight': 258, 'color': 'orange'}, {'fruit': 'banana', 'price': 86, 'weight': 31, 'color': 'green'}, {'fruit': 'apple', 'price': 39, 'weight': 208, 'color': 'green'}, {'fruit': 'peach', 'price': 73, 'weight': 116, 'color': 'orange'}, {'fruit': 'raspberry', 'price': 82, 'weight': 57, 'color': 'purple'}, {'fruit': 'strawberry', 'price': 72, 'weight': 31, 'color': 'pink'}]}, {'id': 3, 'basket': [{'fruit': 'strawberry', 'price': 47, 'weight': 99, 'color': 'orange'}, {'fruit': 'pear', 'price': 40, 'weight': 38, 'color': 'pink'}, {'fruit': 'pear', 'price': 19, 'weight': 182, 'color': 'orange'}, {'fruit': 'watermelon', 'price': 27, 'weight': 249, 'color': 'yellow'}, {'fruit': 'watermelon', 'price': 93, 'weight': 202, 'color': 'red'}, {'fruit': 'apple', 'price': 65, 'weight': 112, 'color': 'purple'}, {'fruit': 'banana', 'price': 24, 'weight': 150, 'color': 'pink'}]}, {'id': 4, 'basket': [{'fruit': 'banana', 'price': 19, 'weight': 271, 'color': 'purple'}]}]

别担心!我们可以从 list 类继承并重写格式化打印列表的神奇方法。

我们所要做的就是使用 json.dumps 函数来获得一个“经典的”json 视图。我们也可以尝试每行打印一行,但这不允许我们看到完整的数据。

[{"id": 0,"basket": [{"fruit": "peach","price": 89,"weight": 121,"color": "red"},{"fruit": "peach","price": 17,"weight": 163,"color": "red"},{"fruit": "watermelon","price": 19,"weight": 36,"color": "yellow"},{"fruit": "watermelon","price": 88,"weight": 39,"color": "blue"},{"fruit": "banana","price": 14,"weight": 131,"color": "purple"},{"fruit": "peach","price": 72,"weight": 94,"color": "yellow"},{"fruit": "raspberry","price": 74,"weight": 285,"color": "pink"},{"fruit": "strawberry","price": 88,"weight": 203,"color": "orange"}]},{"id": 1,"basket": [{"fruit": "pear","price": 77,"weight": 136,"color": "blue"},{"fruit": "peach","price": 7,"weight": 98,"color": "green"},{"fruit": "peach","price": 94,"weight": 292,"color": "green"},{"fruit": "raspberry","price": 23,"weight": 69,"color": "pink"},{"fruit": "watermelon","price": 35,"weight": 120,"color": "pink"}]},{"id": 2,"basket": [{"fruit": "strawberry","price": 52,"weight": 36,"color": "blue"},{"fruit": "pear","price": 42,"weight": 241,"color": "purple"},{"fruit": "pear","price": 66,"weight": 165,"color": "orange"}]},{"id": 3,"basket": [{"fruit": "peach","price": 88,"weight": 219,"color": "blue"},{"fruit": "raspberry","price": 80,"weight": 87,"color": "green"},{"fruit": "apple","price": 42,"weight": 247,"color": "purple"},{"fruit": "banana","price": 97,"weight": 154,"color": "orange"},{"fruit": "banana","price": 37,"weight": 177,"color": "green"}]},{"id": 4,"basket": [{"fruit": "strawberry","price": 48,"weight": 64,"color": "green"}]}

]

访问值

现有方式

假设我们想要访问订单 5 和订单 6 的篮子。

对于数据帧,这非常简单,我们只需使用**。锁定**方法。

但是对于列表,你必须使用列表理解:

新方法

这有点烦人,它返回一个列表,而不是我们刚刚创建的类。因此,就像我们对 str 方法所做的一样,我们可以重写 getitem 魔法方法,它允许我们使用索引和切片来访问元素。

要对行进行过滤,我们只需使用切片父方法。但是要过滤列,我们必须更有创造性,使用字典理解来过滤关键字。

比较性能

现在让我们看看哪种方法更快。

List : 0.025424789999999975 seconds for 10000 iterations

DataFrame : 1.14112228 seconds for 10000 iterations

实际上,用我们的字典列表访问一个值要快得多!

设置值

假设我们想要设置值 id_store 。目前,我们只有一家商店,所以我们将把 id_store 设置为 1。

现有方式

有了数据框架,这是非常方便的。

对于列表,我们可以这样做:

虽然它不是一段很长的代码,但它仍然是两行而不是两行。

新方法

让我们定义另一个神奇的方法,使用括号为每个字典设置一个值。

我们现在可以非常容易地将一个键分配给一个值或一组值:

对比表演

我们的新方法能像熊猫的数据帧一样好吗?让我们再次比较 timeit 模块的性能。

List : 0.852329793 seconds for 10000 iterations

DataFrame : 0.996496461 seconds for 10000 iterations

这一次,列表和数据帧的性能非常相似。

映射列

我们想计算每个订单的总购物篮价格。我们如何做到这一点?

现有方式

数据帧有一个映射功能,对于这种类型的计算非常方便。

对于一个列表,我们再次需要迭代:

新方法

让我们为字典列表创建一个映射函数,让它像熊猫一样简单!这其实很简单,因为我们可以在不同的函数中处理赋值和返回值( map 和 setitem )。

现在,它变得与 DataFrame 映射方法相同。

比较性能

又到了衡量业绩的时候了!

List : 11.182705553 seconds for 10000 iterations

DataFrame : 16.0493823 seconds for 10000 iterations

太棒了,我们的榜单再次成为冠军!

后续步骤

虽然 Pandas 在快速浏览 CSV 文件方面非常出色,但我肯定会更频繁地使用这个新的 DictList 类来对大文件或嵌套文件进行基本转换。

我可能会把这变成一个项目,并创建一个具有更多功能的库。

你会使用这个图书馆吗?要让字典列表成为你最喜欢的结构,你需要什么样的特性?

资源

下面是一些链接,可以探索文章中讨论的一些概念:

- 熊猫文档

- 系统文档

- Tech with Tim 魔术方法视频教程

如何将有向图表示为邻接矩阵

原文:https://towardsdatascience.com/how-to-represent-a-directed-graph-as-an-adjacency-matrix-d4e8135c2fe4

R 中的示例

照片由艾丽西娅鲍威尔,Pixistock。

图表是以直观的方式展示高维数据的绝佳方式。但是当涉及到用矩阵来表示图形时,可能就不那么直观了。在前面的中,我们看到了如何将一个无向图表示为一个邻接矩阵。在本教程中,我们将着眼于把有向图表示为邻接矩阵。

与无向图不同,有向图具有方向性。这通常由从一个节点到另一个节点的箭头表示,表示关系的方向。Twitter 和 Instagram 是有向图的极好例子,因为你可以跟踪一个人,而他们不会跟踪你。现在,让我们开始看看如何用邻接矩阵来表示有向图。对于本教程,我们将使用 visNetwork 包,我们将从查看一个没有回路或自边的有向图开始。

示例 1:没有回路的小型有向图

首先,我们将为 visNetwork 创建一个节点数据帧来初始化我们的网络节点。我们的网络将由 6 个节点组成,标记为 1 到 6。然后,我们将创建一个 edges 数据框来添加节点之间的关系。为了确保网络是定向的,边数据帧将有一个箭头列表示关系的方向。在本例中,所有关系都将从的列流向的列。最后,我们将使用 visNetwork() 绘制我们的网络。

library(visNetwork) # Create nodes dataframe for visNetwork.

nodes <- data.frame (id = 1:6, label = 1:6, color = rep('#8BB1AB', 6)) # Create edges dataframe for visNetwork.

edges <- data.frame(from = c(1, 2, 3, 3, 4, 5), to = c(2, 3, 4, 5, 5, 6), arrows = 'to') # Plot network using visNetwork.

visNetwork(nodes, edges) %>% visOptions(highlightNearest = TRUE, nodesIdSelection = TRUE)

作者图。

类似于我们对无向图所做的,我们让邻接矩阵的行和列代表节点或顶点。这将产生一个正方形矩阵。然而,与无向图不同的是,1 表示从列 j 到行 I 的箭头。注意:你可以反过来看,箭头从列 I 到行 j。确保你知道使用的是哪个版本。

对于上图,邻接矩阵如下所示:

由于从节点 1 到节点 2 有一条边,我们在中看到 1

(第 2 行,第 1 列)。这种方向性经常导致不对称矩阵。此外,我们可以看到对角线完全由零组成,因为从任何节点到其自身都没有边。现在,让我们看一个例子,我们有循环和多边。

示例 2:带有回路和多边的小型有向图

在本例中,我们将保留上面的节点数据框,但指定一个新的边数据框。因为我们想要循环,我们将有一个从 2 到 3 的关系和从 3 到 2 的关系,给我们一个循环。我们将创建的第二种循环是自我边缘,其中关系循环回到自身。我们将通过使关系从 1 到1来建立与节点 1 的自边。最后,我们将把所有新的关系存储在一个名为 edgesMessy 的数据帧中。

# Create new edges dataframe for visNetwork.

edgesMessy <- data.frame(from = c(1, 2, 3, 3, 4, 5, 1, 3, 5, 5), to = c(2, 3, 4, 5, 5, 6, 1, 2, 6, 6),arrows = 'to') # Plot network using visNetwork.

visNetwork(nodes, edgesMessy) %>% visOptions(highlightNearest = TRUE, nodesIdSelection = TRUE)

作者图。

这里,邻接矩阵如下所示:

请注意,循环表示为 1。对于有向图来说,每一个有向关系都是计数的,并且回路只有一个有向关系。(如果节点 1 有两个环路,条目将是 2。)我们还可以看到,节点 5 和 6 之间有三条边。因此,

现在用 3 表示。

概括一下:

- 邻接矩阵总是正方形的

- 有向图的邻接矩阵并不总是对称的

- 没有回路的有向图在对角线上会有零点

- 无向图中的每个循环都用 1 表示

- 邻接矩阵可以解释多条边

原载于 2022 年 2 月 16 日 https://thatdarndata.comhttps://thatdarndata.com/how-to-represent-a-directed-graph-as-an-adjacency-matrix/。

如何恢复 Google BigQuery 意外删除的数据

原文:https://towardsdatascience.com/how-to-restore-data-accidentally-deleted-from-google-bigquery-1ec2a621149f

详细说明,以帮助您恢复意外删除的数据,而不是提前获得任何白发

你有没有在 Google BigQuery 中不小心删除了一个重要的表、视图或者整个数据集?如果有,您知道您不能继续使用包含已删除数据的表和查询。

OWOX 团队已经创建了一个详细的分步说明来恢复被删除的数据,以及一些步骤来防止将来出现类似的问题。

如果已删除的表自删除以来未超过七天,并且您知道其名称和从中删除该表的数据集的名称,则可以恢复该表。

要恢复表,请在 Google BigQuery 界面中打开云 Shell 命令行:

作者图片

输入以下命令:

bq cp mydataset.mytable@-3600000 mydataset.newtable

带有表名和数据集名的相同命令示例:

bq cp OWOXBI_Reports.123_Transactions_withModels@-13600000 OWOXBI_Reports_Restore.123_Transactions_withModels

其中:

- owo xbi _ reports . 123 _ Transactions _ with models-是已删除的数据集和表。

- owo xbi _ Reports _ restore . 123 _ Transactions _ with models-数据集以及要在其中还原数据的表的名称。

- @-13600000 —过去的一段距离(13,600,000 毫秒前),此时您要查找的表仍然存在。例如,如果一个表在 30 分钟前被删除,那么设置时间间隔@ -3600000 就足够了,这是一个小时前(60 秒×60 分钟× 1000)。

输入请求后,需要授权。单击授权按钮:

作者图片

该命令成功运行后,该表将被恢复:

作者图片

您将看到类似以下内容的文本:

Waiting on bqjob_r4ca30008c2e3147d_0000017af0d58e5e_1 ... (0s) Current status: DONE Table 'summer-drive-112011:OWOXBI_Reports_Restore.test_table@-600000' successfully copied to 'summer-drive-112011:OWOXBI_Reports_Restore.test_table'

如何恢复已删除的视图

您不能以上述方式恢复远程视图。那种方法只适用于表。

Google 支持建议使用日志浏览器来恢复已删除的视图。

要查找更新远程视图的查询,请在谷歌云平台日志中运行以下查询:

resource.type="bigquery_resource" protoPayload.methodName="tableservice.update" protoPayload.serviceData.tableUpdateRequest.resource.tableName.tableId="custom_events_attribution_VIEW"

其中:

- tableservice.update —是在日志中显示视图更新的命令

- custom _ events _ attribution _ VIEW 视图的名称

在选择时间范围设置中,设置可对视图进行更改的时间段(例如,一年):

作者图片

执行该命令时,将显示更新了您正在查找的视图的所有查询。选择最后一个时间戳查询:

作者图片

从日志中复制查询并重新创建视图。

作者图片

此外,您可以找到创建您正在寻找的视图的查询(在此之前,我们搜索更新视图的查询)。为此,请使用以下命令:

resource.type="bigquery_resource" protoPayload.methodName="tableservice.insert" protoPayload.serviceData.tableInsertRequest.resource.tableName.tableId="query_name_VIEW"

作者图片

我们建议您设置尽可能长的时间来搜索日志中所需的条目。

如果视图是在开始记录日志之前创建的,则无法恢复。在这种情况下,我们上面描述的 tableservice.update 命令会有所帮助。

如何恢复已删除的数据集

如果您删除数据集,您将无法恢复它。您必须创建一个同名的新数据集,还原已删除数据集中的表和视图,并将它们移动到新的数据集中。

在删除数据集后的前 24 小时内,不能创建同名的新数据集,但仍可以找到属于已删除数据集的表和视图的名称。但是,表和视图本身将不再可见。

通过在 BigQuery 中搜索,可以按名称从已删除的数据集中查找视图:

作者图片

无法通过搜索找到表的列表,因为表的名称中没有公共组件。

若要从已删除的数据集中查找表名,请使用以下 SQL 查询。在查询中,指定可以修改表的时间段(creation_time BETWEEN)。因此,该查询将返回在哪个时间段内对其进行了更改的表。这些将是已删除数据集中的表。

SELECT *

FROM ( SELECT query, user_email, CONCAT(destination_table.project_id,".",destination_table.dataset_id,".",destination_table.table_id) AS destination_table,

COUNT(job_id) AS job_ids,

MAX(creation_time) AS lastUpdateDate

FROM region-us.INFORMATION_SCHEMA.JOBS_BY_PROJECT

WHERE creation_time BETWEEN TIMESTAMP_SUB(CURRENT_TIMESTAMP(), INTERVAL 180 DAY) AND TIMESTAMP_SUB(CURRENT_TIMESTAMP(), INTERVAL 0 DAY) AND state = 'DONE'

AND CONCAT(destination_table.project_id,".",destination_table.dataset_id,".",destination_table.table_id) LIKE "%OWOXBI_Reports.%"

GROUP BY 1, 2, 3

ORDER BY 5 DESC)

作为请求的结果,您将收到以下信息:

- 查询-对 destination_table 进行更改的查询的文本

- 用户电子邮件—启动目标表更新请求的用户

- destination _ table 已更新的表

- job_ids —在指定的时间间隔内开始查询的次数(创建时间介于…)

- last updatedate-查询的上次启动时间(MAX(creation _ time)AS last updatedate)

删除数据集 24 小时后,您可以创建一个同名的新数据集,并开始恢复表和视图。

如何防止将来出现类似问题

- 当您开始使用项目时,在 Google BigQuery 项目中打开日志收集。

- 不要将表命名为数据集,也不要将其视为数据集。

- 仔细检查您想要从 Google BigQuery 中删除的任何表的名称。

- 通过查询删除表,而不是通过用户界面。

- 将实体类型添加到数据集、表和视图名称中。例如:

- OWOXBI _ 报表 _ 数据集

- OWOXBI_report_table

- OWOXBI_report_view

您可以使用查询删除表:

DROP TABLE `summer-drive-112011.OWOXBI_Reports_Restore.test_table`

您还可以使用查询删除视图:

DROP VIEW `summer-drive-112011.OWOXBI_Reports_Restore.test_VIEW`

如果问题再次发生,如何缩小问题的规模

- 不要更改计划和 Google Apps 脚本中的查询;第二天,恢复所有视图和表,之后 Schedule 和 Google Apps 脚本将正常工作。

- 如果视图或表参与了属性模型的设置,您需要在将数据恢复到其先前位置后重新开始属性计算。

关于该主题的有用链接:

恢复删除的表格

删除表格

管理观点

如何在 Google BigQuery 中即时恢复一个表

如何反向编码 R 中的音程音阶

原文:https://towardsdatascience.com/how-to-reverse-code-an-interval-scale-in-r-917c13e4888e

清除问卷和测量数据的简单方法

来自 Pexels 的 Alex Green 拍摄的照片

如果您使用 R 进行数据分析,很可能会遇到处理区间数据的情况。通常,能够在一个区间尺度上反转数据是很有用的。下面是如何做的,有一步一步的例子。如果您希望本文中的所有代码都包含在一个脚本中,请查看最后的 GitHub 要点。

使用调查数据

假设你是一名心理学家,收集了关于人们焦虑体验的数据。你对人们进行了调查,询问他们现在有多焦虑,他们每天经历焦虑想法的频率,等等。你要分析这些数据,给每个参与者的焦虑评分。但是,您使用的调查问卷中有几个措辞相反的问题,而通常的回答量表是反过来的。当你把每个参与者的回答加起来时,你需要颠倒这些答案的编码来得到正确的分数。

幸运的是,在 r 中有一种简单的方法来进行这种分析。

假设我们调查中的每个项目都使用 7 分的李克特量表,如下所示:

“1 =强烈不同意;2 =不同意;3 =有些不同意;4 =既不同意也不反对;5 =有些同意;6 =同意;7 =非常同意”

我们可以通过从这个响应量表中随机取样值来创建一个数据集,如下所示。

library(tidyverse)# Generate some simple data

survey_data <- tibble(participant = 1:7,worried_thoughts = sample(myscale, 7),anxiety_effects = sample(myscale, 7)

)

该数据集的第一列worried_thoughts,包含参与者对陈述“我经常有侵入性的担忧想法”的响应。第二列anxiety_effects,包含对陈述“焦虑很少影响我的日常生活”的响应。

由于第二种说法的措辞,高数字分数表明焦虑感低。这意味着对这一陈述的回答必须进行反向编码,以便与其他正常措辞的问题进行比较,其中高数字分数意味着高焦虑。

幸运的是,这有一个简单的公式。

如何反转区间标度上的值

要在区间标度上反转值,您需要取变量所在标度的最小值,减去要反转的值,然后加上标度的最大值。

这个公式适用于从任何数字(正数或负数)开始的反应等级。它也适用于具有任何大小间隔的标尺,只要该间隔是一致的。

以下是应用此公式反转数据集中数值区间值的几种方法的示例。

myscale <- 1:7# The tidyverse way

survey_data <- survey_data %>%mutate(anxiety_effects_reversed = min(myscale) - anxiety_effects + max(myscale))# The base R way

survey_data$anxiety_effects_reversed <- min(myscale) - survey_data$anxiety_effects + max(myscale)

在这段代码中,我们首先定义问题中使用的数值范围。这只是一个数字 1 到 7 的向量,存储在变量myscale中。

然后,我们可以在反向编码公式中使用myscale中的值。在 tidyverse 示例中,该公式被表示为min(myscale) — response + max(myscale),其中response是要重新编码的列中的值。

这真的很简单,你可以用 Base-R 或 Tidyverse 来应用它,如图所示。在这两个例子中,反向编码操作的结果存储在新列response_reversed中。

反转几个区间标度变量

照片由威廉·沃比在 Unsplash 上拍摄

当您需要翻转数据集中几个问题的尺度时,该怎么办?你可以像以前一样用同样的公式做这件事,只需要一点点小技巧。

对于本例,让我们创建更多的示例数据,这次有多个问题。

# Generate more data

full_survey_data <- tibble(question = unlist(map(1:5, ~ rep(paste0("Question", .), 5))),participant = rep(1:5, 5),response = sample(myscale, 25, replace = T)

)

该数据是长格式的,这意味着在第一列中有多个重复的行。如果你有兴趣,你可以在这里阅读更多关于长数据和宽数据的区别。如果您的问卷数据不是长格式,您可以使用 r 中的 pivot_longer 函数进行转换。

要对数据集中的一些问题进行反向编码,同时保持其他问题不变,我们首先需要选择我们想要重新编码的问题。我们可以通过创建一个包含我们正在记录的问题名称的向量来做到这一点。在这种情况下,我们希望颠倒问题 2 和 3 的得分。

# Define vector of question names that you want to reverse

reverse_questions <- c("Question2", "Question3")

现在,我们可以使用这个向量来选择性地应用我们的重新编码操作。我们可以通过在 mutate 中使用case_when来做到这一点,这是我最喜欢的 tidyverse 函数之一。

full_survey_reversed <- full_survey_data %>%mutate(response = case_when(question %in% reverse_questions ~ min(myscale) - response + max(myscale),TRUE ~ as.integer(response)))

一开始可能会有很多东西需要处理,所以让我们把它分解一下。

这段代码使用了mutate,这是一个操作现有列的值或创建新列的函数。我在上一个例子中也使用了它,但是在这个例子中,我已经设置了它来将我们操作的结果分配给已经在数据中的response列。这意味着它将改变该列中的一些现有值。

然后,case_when函数反转 response 列中的值,但是只针对我们想要重新编码的问题。它的工作原理是根据一个条件检查每一行数据。这里,它检查问题列的值是否在我们前面定义的问题名称向量中。

如果是,它会将比例反转公式应用于“响应”列中的值。您可以在case_when行中的波浪号(~)后看到这一点。如果给定的行不包含我们选择重新编码的问题,case_when将返回 response 列的原始值。它通过TRUE ~ as.integer(response)命令来实现这一点。

这段代码的结果是,对于我们选择的问题,response中的值被反转,对于我们没有选择的问题,值保持不变。

给问卷打分现在很简单。同样,我们使用 tidyverse 函数,这一次是对响应进行求和,以获得每个参与者的分数。

# Sum up each participant's survey score

full_survey_reversed %>%group_by(participant) %>%summarise(total_score = sum(response))

恭喜你!您现在可以轻松地反转 R 音程音阶。对于本文中使用的所有代码,请参见下面的要点。

数据清理快乐!

想阅读我所有关于 R 编程、数据科学等方面的文章吗?在这个链接注册一个媒体会员,就可以完全访问我所有的作品和媒体上的所有其他故事。这也直接帮助了我,因为我从你的会员费中得到一小部分,而不需要你额外付费。

只要我在这里订阅,你就可以把我所有的新文章直接发到你的收件箱里。感谢阅读!

如何运行 A/B 测试

原文:https://towardsdatascience.com/how-to-run-a-b-tests-709d73a5347a

如何使用统计数据对比例进行 A/B 测试的简单指南

作者图片

如果你能不断测试不同的想法,在线营销和创业成长会更好。当我们必须进行 A/B 测试时,这个统计数字就派上用场了。通过适当的分析,你可能获得的结果会给你的项目带来巨大的推动。

什么是 A/B 测试?

公司经常需要将某项行动的结果与另一项行动的结果进行比较,以确定表现最好的行动。一般来说,经常需要检查一组可能的解决方案中哪一个是最佳解决方案。例如,如果您运行一份新闻稿,您可能希望测试同一封电子邮件的不同主题,然后选择打开率最高的主题。这就是 A/B 测试的总体思路。你把你的听众分成两个相等的部分:A 和 c。然后,你根据你要测试的项目(例如,你要测试的对象的数量)把 A 分成两个同样大小的子集。你得到了 A 和 B 子集。重要的是,所有这些集合不要重叠,并且它们必须在统计上相似(即,不能有任何特定的规则来区分彼此)。

然后,您将主题为 1 的电子邮件发送给 A,主题为 2 的电子邮件发送给 b。

一段时间后,您测量 A 和 b 的表现。表现最好的一组将会告诉您哪个选择是成功的。最后,您可以将带有获奖主题的电子邮件发送给受众 c。

如何比较 A/B 测试的结果

假设您的 A/B 测试给出了以下结果:

数据集 A

- 尺寸:2128

- 开口:12

数据集 B

- 尺寸:2128

- 开口:18

数据集 B 给出了比数据集 A 更多的正面事件,所以人们可以认为 B 是赢家。实际上 A 的开放率是 0.56%,B 的开放率是 0.85%。

我们应该选择 B 吗?嗯,当我们处理样品时,事情就不那么容易了。大数定律确保开盘价向其“真实”值收敛,但这些估计值来自样本,因此它们受到有限规模效应的影响。因此,它们的差异可能是由于随机效应,而不是 B 对 a 的真实有效性。

为了解决这个问题,我们必须进行统计分析。

为了统计比较这些数字,我们首先需要计算它们的置信区间,例如 95%的置信度。

我已经讲过比例的置信区间的计算。总的想法是使用正态近似来计算我们估计的置信区间。

对于相当大的 N (通常大于 30)值,比例 p 的 95%置信区间为:

如果我们在数据集上进行这样的计算,我们得到 A 的置信区间是(0.25%,0.88%),而 B 的置信区间是(0.46%,1.23%)。

让我们画出这些间隔,看看会发生什么。

置信区间对比图。图片作者。

正如我们所看到的,虽然 B 的平均值比 A 高,但置信区间彼此重叠。这是典型的有限尺寸效应,因为我们的样本当然是有限尺寸的。

这个图告诉我们,这两个度量在统计上是相似的,因为它们的置信区间重叠。所以,我们不能说 B 比 a 表现得更好。

为了达到显著性水平,我们可以使用正态近似法计算双尾 p 值。

首先,我们计算一个 z 变量的值。

在我们的例子中, z = -1.10

然后,我们计算双边 z 测试的 p 值,其零假设是比例相等。我们得到的值是 13.6%。所以我们可以说,如果比例相等,我们只能在 13.6%的实验中得到这样的极值。如果我们拒绝 p 值小于 5%的零假设,我们不能拒绝本例中的零假设。

我不喜欢使用 p 值,因为它们不能给我们一个明确的答案。相反,我更喜欢可视化置信区间,看看它们是否重叠。然而,如果你在一个广泛使用 p 值的环境中工作,你可以使用一个 z 测试来计算你的 p 值。

A/B 测试清单

因此,这里有一个通用的 A/B 测试方法:

- 计算 A 和 B 的比例

- 根据以下公式计算置信区间

- 将它们可视化并验证它们是否重叠。如果置信区间重叠,你不能说比例在统计学上有差异。如果它们没有重叠,你可以有 95%的把握说它们是不同的

一个方便的网络应用程序

可以在 Python、R 甚至 Excel 中执行 A/B 测试。但是,如果您需要快速的结果,并且不想自己开发应用程序,我已经创建了一个简单的 web 应用程序,它将为您计算置信区间和 p 值。您可以在所有测试中随意使用它。

结论

A/B 测试是初创企业成长的标准方法。他们真的能够让一家初创公司迅速扩大规模,因为他们能够快速、成功地验证任何可能的想法。然而,为了从 A/B 测试中提取最大值,您必须始终使用正确的统计数据。

原载于 2022 年 5 月 20 日 https://www.yourdatateacher.comhttps://www.yourdatateacher.com/2022/05/20/how-to-run-a-b-tests/。

如何在 Docker 容器中运行数据科学项目